ADVERTISEMENT

如今大型語言模型(如 ChatGPT)風靡全球,其最重要的應用之一就是輔助使用者完成各種日常寫作,如撰寫電子郵件,創作部落格文章,都能得到它的有力支援。但是目前包括 ChatGPT 在內的各種大語言模型在長內容創作領域,如小說,劇本,長篇文案等領域卻顯得力不從心。

近期,來自蘇黎世聯邦理工和波形智慧的團隊發表了 RecurrentGPT,一種讓大語言模型 (如 ChatGPT 等) 能夠模擬 RNN/LSTM,透過 Recurrent Prompting 來完成互動式超長文本寫作,讓利用 ChatGPT 進行長篇小說創作成為了可能。

- 論文地址:https://arxiv.org/abs/2305.13304

- 專案連結:https://github.com/aiwaves-cn/RecurrentGPT

- 線上 Demo:

基於 Transformer 的大語言模型最明顯的限制之一就是輸入和輸出的長度限制。雖然輸入端的長度限制可以透過 VectorDB 等方式緩解,輸出內容的長度限制始終是限制 ChatGPT 等大語言模型廣泛應用於長內容生成的關鍵障礙。為解決這一問題,過去很多研究試圖使用基於向量化的 State 或 Memory 來讓 Transformer 可以進行迴圈計算。這樣的方法雖然在長文本建模上展現了一定的優勢,但是卻要求使用者擁有並可以修改模型的結構和參數,這在目前閉源模型遙遙領先的大語言模型時代中是不符合實際的。

RecurrentGPT 則另闢蹊徑,是利用大語言模型進行互動式長文本生成的首個成功案例。它利用 ChatGPT 等大語言模型理解自然語言指令的能力,透過自然語言模擬了循環神經網路(RNNs)的循環電腦制。

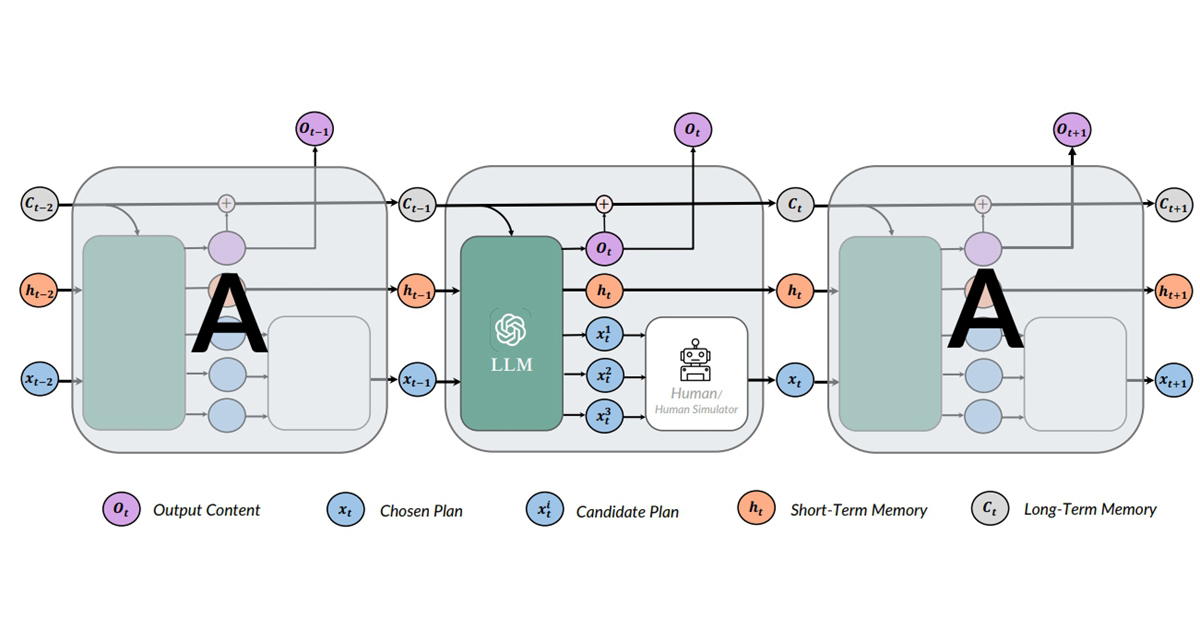

如下圖所示,在每一個時間步中,RecurrentGPT 會接收上一個時間步生成的內容、最近產生的內容摘要(短期記憶),歷史生成內容中和當前時間步最相關的內容 (長期記憶),以及一個對下一步產生內容的大綱。RecurrentGPT 根據這些內容產生一段內容,更新其長短時記憶,並最後產生幾個對下一個時間步中產生內容的規劃,並將當前時間步的輸出作為下一個時間步的輸入。這樣的迴圈電腦制打破了常規Transformer 模型在創作長篇文本方面的限制,進而實現任意長度文本的生成,而不遺忘過去的資訊。

具體來講。作者們設計了如上圖所示的 prompt 去指導和規範迴圈的產生:

首先指明任務,比如寫小說,並說明在輸入部分會給出的內容:上一步產生的段落(圖中 Ot-1)、當前維持的近期產生內容的摘要,即短期記憶(圖中 ht-1),所有產生內容中和當前時間步相關程度最高的幾個段落,即短期記憶(圖中 ct-1),以及對接下來產生內容的規劃(圖中 xt-1)。

接著在 prompt 中給 ChatGPT 提出要求:首先基於當前的輸入產生一個新的段落,接著對維護的短期記憶進行修改,同時在對短期記憶修改時作者們指示大語言模型首先分析短期記憶中哪些內容對於後續創作不再重要以及新產生的內容中哪些會對後續生成有所影響,之後相應地在地短期記憶庫中去去除無用的資訊並增添新的資訊,進而保持短期記憶不會因為反覆運算的輪數增加而變得過長。最後要求 ChatGPT 基於當前的情節鋪設,給出三個邏輯順承又有趣的新的情節的規劃。

在提出要求後,作者在結尾再次精心設計了 prompt 來規範 ChatGPT 的輸出,並重申了當前小說寫作的情景。這個好處是讓 ChatGPT 產生的內容更具備像小說那樣的細節,而不是在每一輪的反覆運算中,快速地完成情節的敘述。

在實際使用中,內容創作者只需先選擇一個主題,然後簡單地描述一下要生成的內容的背景設定和大綱,剩下的工作就可以交給 RecurrentGPT。每一個它將自動產生第一段,並提供幾個可能的選項(plan)供創作者繼續寫故事。創作者可以選擇一個選項、對某個選項進行修改或者自己編輯一個新的選項。這個流程能顯著提高內容創作者的效率。

這個新的長文本生成典範將帶給所有內容創作者和讀者一種全新的體驗。首先,相比現有的方法,RecurrentGPT 有更強的可解釋性,因為使用者可以觀察和編輯自然語言記憶,這使得使用者可以更清晰地理解這個框架是如何工作的。其次,使用者可以直接影響產生內容的方向,讓整個寫作過程變得更加有趣。

除了作為 AI 內容生成 (AIGC) 的工具以外,RecurrentGPT 可以直接作為互動式小說,直接與消費者互動,跳過了內容創作者使用 AI 進行內容創作的步驟。這讓消費者的體驗更直接有趣,並且帶來更豐富的可能性。作者們將這樣的生成式 AI 的使用典範稱之為 (AI as Content, AIAC), 也就是「AI 即內容」。而 RecurrentGPT 則是通往這個典範的第一步。

在實驗中,作者們將 RecurrentGPT 與之前的 SoTA 長文本產生方法,在統一使用 ChatGPT 作為基座模型的情況下,在長文本(6000 單詞)和較長文本(3000 單詞)的設定下進行 pair-wise 的人工比較。

在上述一系列測試中,RecurrentGPT 無論是在科幻、浪漫、幻想、恐怖、神秘還是驚悚小說的生成上,都被人類讀者認為更有趣和連貫。

總結

研究人員提出了 RecurrentGPT,用基於自然語言的元件取代了 RNN 中向量化的結構,並且用基於自然語言的 Prompt 類比了 RNN 的迴圈計算圖,進而實現 Recurrent Prompting,讓 ChatGPT 等大語言模型類比 RNN 的迴圈電腦制,產生有趣並連貫的長內容。

該項目已經在 GitHub 上開源,並提供了基於 Gradio 的網頁 UI,方便每一個使用者去使用和調教自己的長內容創作助手。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!