ADVERTISEMENT

現在做個電影級的影片,只要輸入一句話就可以辦到。例如只要輸入「叢林(Jungle)」,電影鏡頭立刻呈現。

而且圍繞著「叢林」變換幾個搭配的詞語,比如「河流」、「瀑布」、「黃昏」、「白天」等,這個AI也能馬上了解你的意思。

下面這些自然美景、宇宙奇觀、微觀細胞等高解決度影片,統統只需一句話。

這就是Stable Diffusion和《媽的多重宇宙》背後技術公司Runway,出品的AI影片編輯工具Gen2。

而且就在最近,突然有了個好消息——Gen2可以免費試用了!

這下網友們紛紛開始嘗鮮。

體驗Gen2

如此好玩的技術,當然也要親驗一下。例如在Gen2裡輸入一句「上海外灘夜景,影視風格。」

一個航拍視角的影片片段便立即被做了出來。

如果想讓影片的風格變換一下,也可以上傳一張圖片,例如我們用的是一張賽博龐克風格的城市照片。

那麼Gen2就會把你輸出的提示詞和照片風格做一個「合體」:

目前Runway官網可免費體驗Gen2的功能是文字產生影片(Text to Video),但Gen1也開放了影片產生影片(Video to Video)的功能。

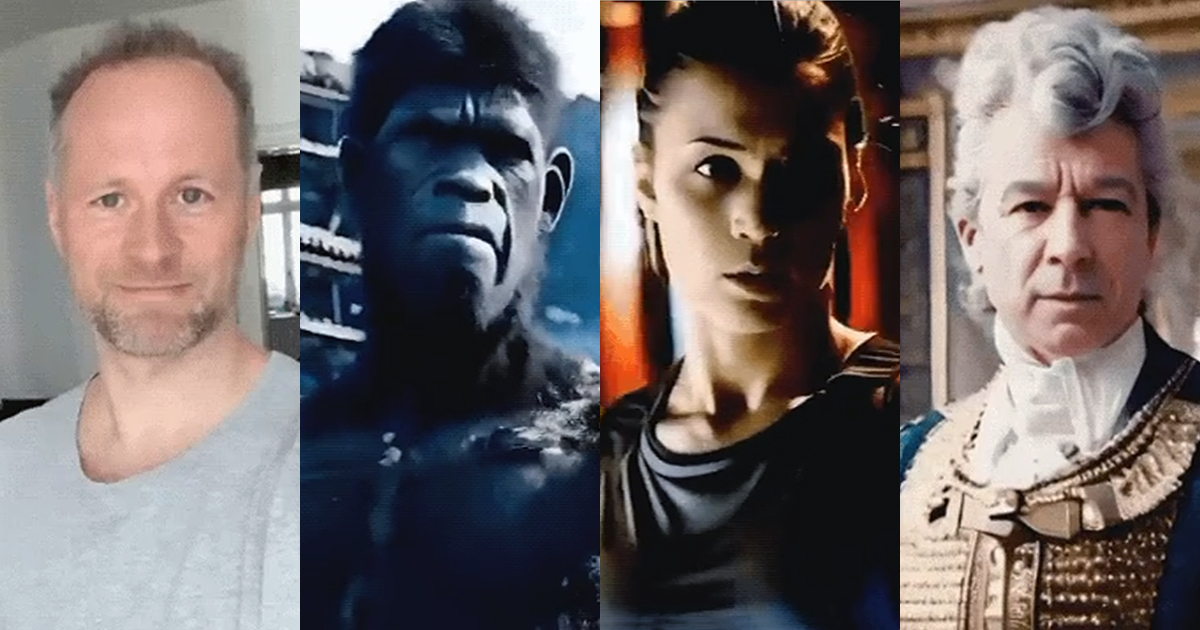

例如一個國外網友可能受《媽的多重宇宙》的啟發,憑藉Gen1也能玩刺激的穿越。

他先是在家錄了一段打響指的影片,然後「啪的一下」,瞬間讓自己步入歐洲皇室貴族的「片場」:

然後……就連物種、性別,都可以隨隨便便地切換:

最後,再經歷幾次不同時空、人種的穿越之後,小哥一個響指又回到了自己的家裡:

在看完Gen2生成的這波「大秀」之後,網友們驚呼:

娛樂圈要被生成式AI重新定義了。

PC、手機都能玩

網頁端和行動端(僅限iOS系統)現在均可正式開始體驗。

If you can imagine it, you can generate it.

— Runway (@runwayml) June 7, 2023

Gen-2 is now available on web and mobile: https://t.co/KctIodJz2t pic.twitter.com/tbo1t7JGeJ

以網頁端為例,進入Runway官方網頁,點擊上方「TRY NOW」並註冊帳號,就可以進入下面的介面:

點擊右方的「Introducing Gen2」,我們就可以正式開玩了。

首先,輸入提示詞,最多320個字元,然後在左邊的設定功能表裡進行一些基礎設定(包括種子參數、插值等),點擊「Generate」。

(當然,你也可以為影片提供一張參考圖像,點擊右邊的圖像圖示即可。)

不到1分鐘的功夫,影片就出來了。

點擊下方播放按鈕即可查看效果,影片可以直接保存到本地端,也可以只保存在你的帳戶中。

當然,如果你對成品不滿意,還能在下方的提示詞框中繼續修改。

需要注意的是,免費試用的額度為105秒(右上角會顯示剩餘額度),每個影片為4秒,也就是大約可免費產生26個Gen2影片。

額度用完後或者你想去除浮水印、提升解析度等額外功能,就需要加入付費會員,標準版為12美元一個月,Pro版是28美元一個月,一次付一年可以打八折。

如果你想要生成效果更好,可以多使用「in the style of xxx」的形式,比如:

A palm tree on a tropical beach in the style of professional cinematography, shallow depth of field, feature film.(如下圖)

A palm tree on a tropical beach in the style of 2D animation, cartoon, hand drawn animation.

或者直接去它的靈感庫,選擇一個你喜歡的影片然後點擊「try it」即可查看它的提示詞是怎麼寫的,然後在上面進行編輯或模仿就好了:

還有網友表示,使用「cinematic shot of」開頭,也能讓你的影片更具動感(解決了很多人試出來的影片不怎麼會動的問題)。

什麼來歷?

Gen2於今年3月20日正式發表,經歷了兩個多月的內測,現在終於正式上線。它的前代Gen1只比它早了一個多月(2月發表),所以說迭代速度相當快。

作為一個基於擴散的生成模型,Gen1透過在預訓練圖像模型中引入時間層,並在圖像和影片資料上進行聯合訓練,完成了潛擴散模型到影片生成領域的擴展。

其中也包括使用一種全新的引導方法完成了對生成結果時間一致性的精確控制。

其架構如圖所示:

在訓練階段,先用固定編碼器將輸入影片x編碼為z0,並擴散為zt。

然後對MiDaS獲得的深度圖進行編碼,提取出結構表示s;再用CLIP對其中一個影格進行編碼來獲取內容表示c。

接著,在s的説明下,模型學習反轉潛空間中的擴散過程(其中s與c以及透過交叉注意塊生成的c相連)。

在推理階段,模型以相同的方式提供輸入影片的結構s。

為了透過文本生成內容,作者還透過一個prior將CLIP文本嵌入轉換為圖像嵌入。

最終,Gen1可以生成細細微性可控的影片,也能對一些參考圖像進行定制。

不過,一開始對公眾發表的Gen1只能對已有影片進行編輯,Gen2才直接完成了文字產生影片的「蛻變」。

並且一口氣帶來了另外7大功能,包括文本+參考圖像生影片、靜態圖片轉影片、影片風格遷移等等。

這樣的Gen2,也在內測階段就被網友稱讚「影片界的Midjourney」。

而根據官方的調查研究資料,Gen2的確更受使用者歡迎:使用者得分比Stable Diffusion 1.5要高73.53%,比Text2Live則高上了88.24%。

如今正式上線以後,果然迅速迎來一大波體驗群眾,有人表示:

上一次有這麼激動的感覺,還是用AI生成圖像的時候。

那麼,不知道這波,參與開發了SD的Runway,能否再帶著Gen2創造生成式AI領域的下一大熱趨勢——

資料來源:

- Advancing creativity with artificial intelligence.

- Gen-2: The Next Step Forward for Generative AI

- https://twitter.com/SteveMills/status/1666799229996785666

- https://twitter.com/runwayml/status/1666429706932043776

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!