ADVERTISEMENT

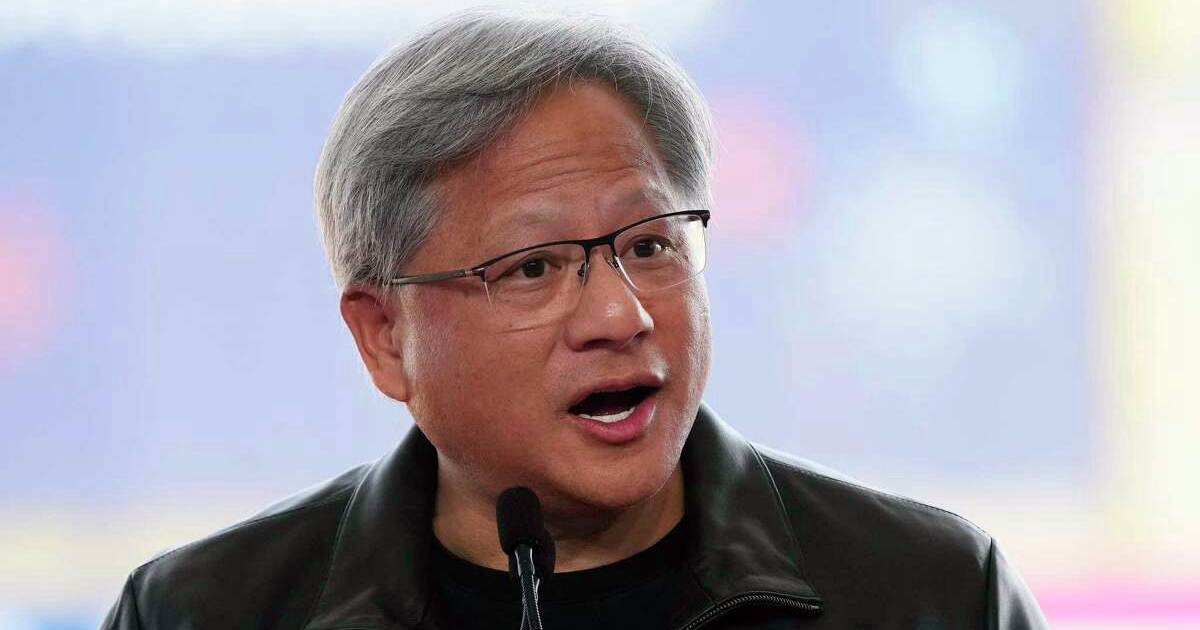

身穿皮夾克的黃仁勳,站在藍色衝浪板上,擺了幾個衝浪的姿勢。 這是美國知名資料平臺 Snowflake 的開發者大會上的一幕。

當地時間 6 月 26 日,Nvidia創始人黃仁勳和 Snowflake 公司 CEO Frank Slootman 就「如何把生成式 AI 帶給企業用戶」展開探討。主持人則是前 Greylock 的 GP,現在是投資機構 Conviction 的創始人。

在會上,相較於「東道主」Frank 職業經理人式的老成持重,「皮衣教父」一如既往地語出驚人,不僅稱雙方的合作是「要相愛,不要相鬥」(We are Lovers,not Fighters),更開玩笑說,為 Snowflake 提供的經過訓練的模型,相當於給客戶「打了 1 折」。

當天,Nvidia與 Snowflake 又共同放出大絕招:世界第一晶片公司與風頭最勁的雲端資料平臺合作,推出共同合作。Snowflake 的使用者可以在資料不離開平臺的前提下,直接利用Nvidia的預訓練 AI 模型,在雲平臺上對自己公司的資料進行分析,開發針對自己資料的「AI 應用」。

「目前的重大變革來自資料+AI 演算法+運算引擎。透過我們的合作,我們的能夠將這三點帶到一起。」黃仁勳講道。

Talking Points:

- 大語言模型+企業專屬資料庫=針對特定問題的 AI 應用;

- 以前是 Data going to Work,現在是 Work going to Data,讓運算去到資料所在之地,避免資料孤島;

- Nvidia提供的預訓練模型,已經是花費數千萬美元、在Nvidia AI 工廠中訓練出來的,所以在 Snowflake 上呼叫運算引擎已經「打了 0.5 折」;

- 軟體 3.0 時代,基於模型、資料庫,企業能夠在幾天內搭建自己的專屬應用;

- 未來企業能夠生產許多智慧代理,並執行它們;

- 對於企業來說,真正的難題是混合結構的、非結構化的資料,如何被調動。這或許能夠帶來商業模式的更新。

以下為雙方對話主要內容,經整理編輯:

談合作:把最好的運算引擎, 帶給最有價值的資料

Frank:

NIVIDA 目前在歷史上發揮著重要的作用。對於我們來說,能夠帶來資料和大型企業的關係。我們需要啟用這項技術,以及讓整個服務堆疊來有效地使用它。我不想使用「天作之合」來形容,但是對於一個門外漢,是一個很好的機會,進入到這扇機會的大門裡。

黃仁勳:

我們是 lovers,而不是對手。我們要把世界上最好的運算引擎帶到世界上最有價值的資料。回想過去,我已經工作了很長時間,但是還沒有那麼老。Frank,你更老一些(笑)。

最近,由於眾所周知的原因,資料是巨大的,資料是寶貴的。它必須是安全的。移動資料很困難,資料的引力真實存在。因此,對我們來說,把我們的運算引擎帶到 Snowflake 上要容易得多。我們的夥伴關係是加速 Snowflake,但它也是關於將人工智慧帶到 Snowflake。

最核心的是,資料+人工智慧演算法+運算引擎的組合,我們的夥伴關係將所有這三件事結合在一起。令人難以置信的有價值的資料,令人難以置信的偉大的人工智慧,令人難以置信的偉大的運算引擎。

我們可以一起做的事情,是説明客戶使用他們的專有資料,並用它來編寫 AI 應用程式。你知道,這裡的重大突破是,你第一次可以開發一個大型語言模型。你把它放在你的資料前面,然後你與你的資料交談,就像你與一個人交談一樣,而這些資料將被增強到一個大型語言模型中。

大型語言模型加知識庫的組合等於一個人工智慧應用。這一點很簡單,一個大型的語言模型將任何資料知識庫變成一個應用程式。

想想人們所寫的一切驚人的應用程式。它的核心始終是一些有價值的資料。現在你有一個查詢引擎通用查詢引擎在前面,它超級智慧,你可以讓它回應你,但你也可以把它連接到一個代理,這是 Langchain 和向量資料庫帶來的突破。將資料和大語言模型疊加的突破性的東西正在到處發生,每個人都想做。而 Frank 和我將幫助大家做到這一點。

軟體 3.0:建立 AI 應用, 解決一個特定問題

主持人:

作為投資者來看這種變化,軟體 1.0 是非常確定的程式碼,由工程師按照功能寫出來;軟體 2.0 是用仔細收集的標記的訓練資料最佳化一個神經網路。

你們在説明人們撬動軟體 3.0,這套基礎模型本身有令人難以置信的能力,但它們仍然需要與企業資料和自訂資料集合作。只是針對它們去開發那些應用程式要便宜得多。

對於那些深入關注這個領域的人來說有一個問題,基礎模型是非常泛化,它可以做所有事情嗎?為什麼我們需要自訂模型和企業資料呢?

Frank:

所以我們有非常泛化的模型,可以做詩,處理《大亨小傳》的做摘要,做數學問題。

但是在商業中,我們不需要這些,我們需要的是一個 Copilot,在一個非常狹窄,但是非常複雜的資料集上獲得非凡的洞見。

我們需要瞭解商業模式和商業動態。這樣的運算上不需要那麼昂貴,因為一個模型並不需要在一百萬件事情上接受訓練,只需要知道非常少的、但很深入的主題。

舉個例子。我是 Instacart 的董事會成員,我們一個大客戶,像 DoorDash 和所有其他企業常面臨的問題是,他們不斷增加行銷費用,來了一個客戶,客戶下了一個訂單,客戶要嘛不回來,要嘛 90 天後回來,這非常不穩定。他們把這稱為流失客戶。

這是複雜問題的分析,因為客戶不回來的原因可能有很多。人們想找到這些問題的答案,它在資料中,不在一般的網際網路中,而且可以透過人工智慧找出來。這就是可能產生巨大價值的例子。

主持人:

這些模型應該如何與企業資料互動?

黃仁勳:

我們的戰略和產品是各種尺寸、最先進的預訓練模型,有時你需要創建一個非常大的預訓練模型,以便它可以產生 prompt,來教更小的模型。

而較小的模型幾乎可以在任何設備運行,也許延遲非常低。然而它的泛化能力並不高,zero shot(零樣本學習)能力可能更有限。

因此,你可能有幾種不同類型不同大小的模型,但在每一種情況下,你必須做監督的微調,你必須做 RLHF(人類回饋的強化學習),以便它與你的目標和原則保持一致,你需要用向量資料庫之類的東西來增強它,所以所有這些都彙集在一個平臺上。我們有技能、知識和基本平臺,幫助他們創建自己的人工智慧,然後將其連接 Snowflake 中的資料。

現在,每個企業客戶的目標不應該是思考我如何建立一個大型的語言模型,他們的目標應該是,我如何建立一個人工智慧應用程式來解決特定的問題?那個應用可能需要 17 個問題來做 prompt,最終得出正確的答案。然後你可能會說,我想寫一個程式,它可能是一個 SQL 程式,可能是一個 Python 程式,這樣我就可以在未來自動做這個。

你還是要引導這個人工智慧,讓他最終能給你正確的答案。但在那之後,你可以創建一個應用程式,可以作為一個代理(Agent)24/7 不間斷地運行,尋找相關情況,並提前向你彙報。所以我們的工作就是説明客戶建立這些人工智慧的應用,這些應用是有安全護欄的、具體的、定制的。

最終,我們在未來都將成為智慧製造商,當然雇用員工,但我們將創建一大堆代理,它們可以用 Lang Chain 類似的東西來創建,連接模型、知識庫、其他 API,在雲中部署,並將其連接到所有的 Snowflake 資料。

你可以規模化地操作這些 AI,並不斷地完善這些 AI。因此,我們每個人都將製造 AI、運行 AI 工廠。我們將把基礎設施放在 Snowflake 的資料庫,客戶可以在那裡使用他們的資料,訓練和開發他們的模型,操作他們的 AI,因此,Snowflake 將是你的資料儲存庫和銀行。

有了自己的資料金礦,所有人都將在 Snowflake 上運行 AI 工廠。這是目標。

「核彈」雖貴,直接用模型相當於「打 1 折」

黃仁勳:

我們在 NIVIDA 建立了有五個 AI 工廠,其中四個是世界前 500 名的超級電腦,另一個正在上線。我們使用這些超級電腦來做預訓練模型。因此,當你在 Snowflake 中使用我們的 Nemo AI 基礎服務時,你將得到一個最先進的預訓練模型,已經有幾千萬美元的費用投入其中,更不用說研發投入了。所以它是預先訓練好的。

然後有一大堆其他的模型圍繞著它,這些模型用於微調、RLHF。所有這些模型的訓練成本都要高得多。

因此,現在你已經將預訓練模型適應於你的功能,適應於你的護欄,最佳化你希望它具有的技能或功能類型,用你的資料增強。因此,這將是一個更具成本效益的方法。

更重要的是,在幾天內,而不是幾個月。你可以在 Snowflake 開發與你的資料連接的人工智慧應用程式。

你應該能夠在未來快速建立人工智慧應用程式。

因為我們現在看到它正在即時發生。已經有一些應用能夠讓你和資料聊天,比如 ChatPDF。

主持人:

是的,在軟體 3.0 時代,95% 的培訓費用已經由別人承擔了。

黃仁勳:

(笑)是的,95% 的折扣,我無法想像一個更好的交易。

主持人:

這是真正的動力,作為投資人,我看到在分析、自動化、法律等領域的非常年輕的公司,他們的應用已經在六個月或更短的時間內實現了真正的商業價值。其中一部分原因是他們從這些預先訓練好的模型開始,這對企業來說是一個巨大的機會。

黃仁勳:

每家公司都會有數百個,甚至 1000 個人工智慧應用程式,只是與你公司的各種資料相連。所以,我們所有人都必須善於構建這些東西。

原來是資料找業務,現在是業務找資料

主持人:

我一直從大企業參與者聽到的一個問題是,我們必須去投資人工智慧,我們需要一個新的堆疊(Stack)嗎?應該如何考慮與我們現有的資料堆疊相連?

Frank:

我認為它在不斷發展。模型們正逐漸變得更簡潔、安全、更好地被管理。所以,我們沒有一個真正明確的觀點,這就是每個人都會使用的參考架構?有些人將有一些中央服務的設定。微軟有 Azure 中的人工智慧版本,它們的很多客戶正在與 Azure 進行互動。

但我們不清楚什麼模型將主導,我們認為市場將在使用難易、成本這些事上進行自我排序。現在僅僅是開始,不是最終的狀態。

安全部門也會參與進來,關於版權的問題會被革新。現在我們對技術很著迷,現實中的問題也會被同時處理。

黃仁勳:

我們現在正經歷 60 年來第一次根本性的運算平臺變革。如果你剛剛讀了 IBM System 360 的新聞稿,你會聽到關於中央處理單元、IO 子系統、DMA 控制器、虛擬記憶體、多工、可擴充運算向前和向後端相容,而這些概念,實際都是 1964 年的東西,而這些概念幫助我們在過去六十年來,不斷進行 CPU 擴充。

這樣的擴充已經進行了 60 年了,但這已經走到了盡頭。現在大家都明白,我們無法再擴充 CPU 了,突然之間,軟體變化了。軟體的編寫方式,軟體的操作方式,以及軟體能做的事情都與以前有很大的不同。我們稱之前的軟體為軟體 2.0。現在是軟體 3.0。

事實就是,運算已經從根本上改變了。我們看到兩個基本的動力在同時發生,這也是為什麼現在事情正在發生劇烈震盪。

一方面,你不能再不斷地購買 CPU。如果你明年再買一大堆 CPU,你的運算輸送量將不會增加。因為 CPU 擴充的終點已經到來了。你會多花一大堆錢,你不會得到更多的輸送量。因此,答案是你必須去加速(Nvidia加速運算平臺)。圖靈獎獲得者談到了加速,Nvidia開創了加速,加速運算現在已經到來。

另一方面是,電腦的整個作業系統發生了深刻的改變。我們有一個叫 NIVIDA AI Enterprise 的層,而其中的資料處理、訓練、推理部署,整個現在已經整合到或正在整合到 Snowflake 中,因此,從開始資料處理,一直到最後的大模型部署,整個背後的運算引擎都被加速了。我們將賦能 Snowflake,在這裡你將能夠做得更多,而且你將能夠用更少的資源做到更多。

如果你去任何一個雲,你會看到 NVIDIA GPU 是其中最昂貴的運算實體。但是,如果你把一個工作負載放在上面,你會發現我們做得非常快。就好像你得到了一個 95% 的折扣。我們是最昂貴的運算實體,但我們是最具成本效益的 TCO。

所以,如果你的工作是運行工作負載,可能是訓練大型語言模型,可能是微調大型語言模型,如果你想這樣做,一定要進行加速。

加速每一個工作負載,這就是整個棧的重塑。處理器因此發生變化,作業系統因此不同,大的語言模型是不同的,你寫 AI 應用程式的方式是不同的。

未來,我們都要寫應用。我們都要把我們的 prompt 和我們的上下文,和少數幾個 Python 命令連接起來,連接到大語言模型和自己的資料庫或者公司的資料庫中,開發自己的應用程式。每個人都將成為一個應用程式的開發者。

主持人:

但不變的是,它仍然是你的資料。你仍然需要對它進行微調。

Frank:

原來我們都覺得更快的總是更貴的。實際上突然之間,更快的是更便宜的,這是一種反直覺的東西。因此,有時人們想減少供應,以為這樣更便宜,結果卻更貴。

另一個與之前矛盾的是,原來都是資料去找業務(data going to work),而現在,業務去找資料 (work going to data)。過去的六十年,或者更多年,我們一直在讓資料去找業務,這導致了大規模的資訊孤島。而如果你想擁有一個 AI 工廠,用之前的做法將是非常困難的。我們必須把運算帶到資料所在的地方。我認為我們現在正在做的就是正確的方式。

企業如何獲得最快和最大的價值

Frank:

最快和獲得最大價值其實是兩個很不一樣的問題。

最快的話,你很快能夠看到,資料庫各處都上線了人工智慧增強的搜尋方式,因為這是最容易增加的功能。現在,甚至一個文盲都能從資料中獲取有價值的資訊,這真非常不可思議,這是終極的互動民主化。搜尋功能極大增強,你就向主介面提一個問題,它們可以把這些問題帶到資料自己進行查詢。這是掛在低處的果實,最容易的,我們認為這是階段一。

接下來,我們就開始真正關注真正的難題,就是專有的企業資料,混合結構化的、非結構化的,所有這些,我們如何調動這些資料?

我前面已經提到了 to C 企業面臨的流失率問題,供應鏈管理方面的問題。當供應鏈特別複雜的時候,如果有一個事件發生了,我們如何重新調整一個供應鏈,使其運轉?我現在該怎麼做?供應鏈是由很多不同的實體組成的,不是單一的企業。歷史上,這是一個從未被運算解決過的問題。供應鏈管理從來沒有形成過一個平臺,它幾乎是一個電子郵件,試算表形成的體系,除了一些小的例外。因此,這是極其令人興奮的。

或者我們可以重新運算大型的呼叫中心的投資,最佳化零售的定價,像我說的,這是一個大企業的 CEO 們一直期待的重新定義商業模式,是真正的潛力。

對企業的建議:

黃仁勳:

我會問自己,第一,什麼是我唯一最有價值的資料庫?第二件事,我會問自己,如果我有一個超級、超級、超級聰明的人,而企業的一切資料都經過那個超級智慧,我會問那個人什麼?

根據每個人的公司,這是不同的。Frank 的公司客戶資料庫非常重要,因為他有很多客戶。而我自己的公司,沒有那麼多客戶,但對我的公司而言,我的供應鏈超級複雜,而且我的設計資料庫也超級複雜。

對 NIVIDA 來說,沒有人工智慧我們已經無法建造出GPU。因為我們的工程師都不可能像AI那樣,為我們進行大量的反覆運算和探索。因此,當我們提出人工智慧的時候,第一個應用在我們自己的公司。而且,所以 Hopper(Nvidia超級電腦)不可能沒有人工智慧的設計。

我們也會將我們自己的 AI 應用於我們自己的資料中。我們的錯誤資料庫就是一個完美的應用場景。如果你看一下 NIVIDA AI 的程式碼量,我們有幾百個套裝軟體,結合在一起,支援一個應用程式能夠跑起來。我們現在正在努力的一些事情,就是如何使用 AI 去弄清楚如何為它安裝安全修補程式,如何最好地維護它,這樣我們就可以不必干擾整個上層應用層的同時,能夠向後端相容。

這都是 AI 能夠為你提供答案的。我們可以用一個大語言模型去回答這些問題,為我們找到答案,或者向我們揭示一些問題,然後工程師就可以再將其修好。或者 AI 可以推薦一個修復方法,人類工程師再去確認這是不是一個好的修復方法。

我覺得不是所有人都認識到了他們每天都在處理的資料裡面,其實蘊含著多少智慧、洞見和影響力沒有被發掘。這就是為什麼我們所有人都要參與進來,幫助帶來這樣的未來。

現在,你儲存在資料倉庫的資料,第一次可以被連接進人工智慧工廠。你將能夠生產資訊情報,這是世界上最有價值的商品。你坐在一個自然資源的金礦上——你公司的專有資料,而我們現在把它連接到一個人工智慧引擎上,另一端每天直接產生資訊情報,以難以置信的情報量從另一端湧出,甚至在你睡覺時也在源源不斷地產出。這是有史以來最好的事情。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!