ADVERTISEMENT

從圖像影片合成、音樂到剪輯,所有一切都是由 AI 完成的。製作者 Nicolas Neubert 列出了對應的 AI 工具,其中 Midjourney 處理圖像、Runway 處理影片、Pixabay 處理音樂、CapCut 剪輯影片。

Midjourney 是大家熟悉的 AI 繪圖神器,目前已經更新到了 5.2 版本。Runway 是基於 AI 的影片製作生成工具,目前 Gen-2 已經開啟免費試用。CapCut 剪輯工具對所有人免費,不過也可以選擇在 Adobe Premier 或 Final Cut Pro 中剪輯。

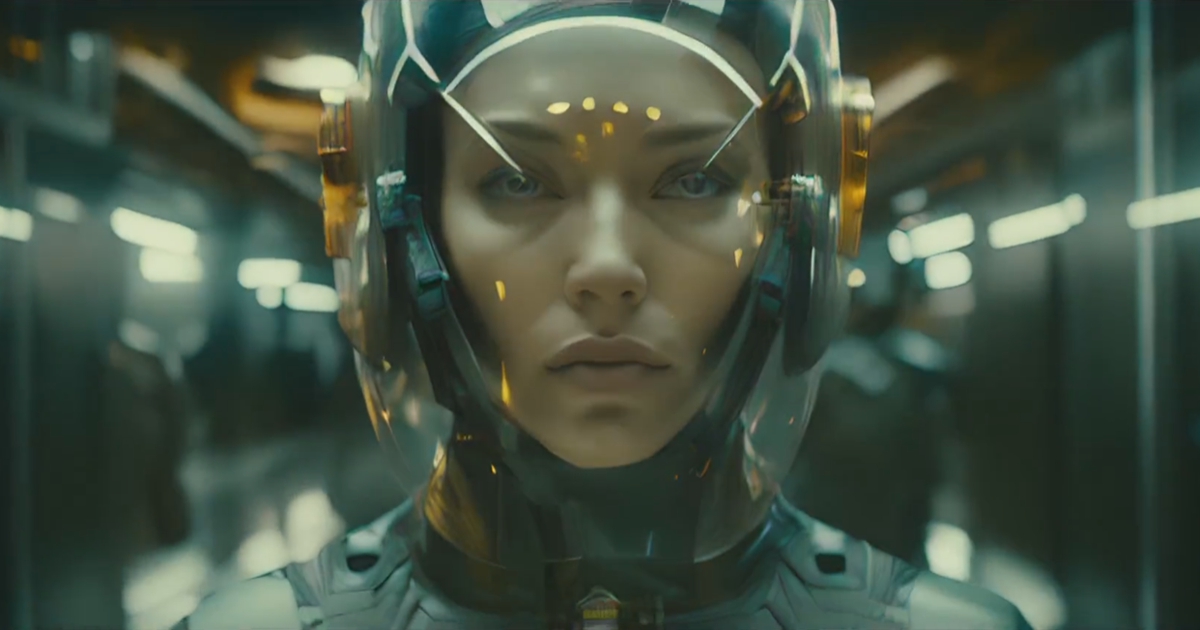

🎬 Trailer: Genesis (Midjourney + Runway)

— Nicolas Neubert (@iamneubert) July 26, 2023

We gave them everything.

Trusted them with our world.

To become enslaved - become hunted.

We have no choice.

Humanity must rise again to reclaim.

Images: Midjourney

Videos: #Runway

Music: Pixabay / Stringer_Bell

Edited in: CapCut pic.twitter.com/zjeU7YPFh9

據瞭解,Neubert 花了 7 個小時,Midjourney 生成了 316 條提示詞、放大了 128 張圖像,Runway 生成了 310 個影片,還有一個帶有文本的影片,預告片中共使用了 44 個影片。

今天,Neubert 更是撰寫了一篇長文,詳細介紹了《創世紀》的製作過程,包含了具體流程、如何使用上述 AI 工具。我們一一來看。

關於電影想法,他表示自己反烏托邦主題的想法來自自己看過的幾部電影,並以它們為基礎編寫了一個故事。

正式製作的第一步是構建世界和故事。

對於預告片《創世紀》的故事情節,Neubert 想一步步地增強緊張感。因此定義了以下 3 個階段:

- 設定場景

- 引入威脅

- CTA 中的高潮

具體地講,Neubert 先製作預告片的第一個文案草稿,包括「分享一切、承擔後果然後呼籲人類採取行動」。

這樣定義了整體基調後,他開始圍繞這些主題生成相應的場景。Neubert 滾動了大量有關環境、軍事科技、戰鬥主題的人類和科幻剪輯,然後從中收集到一個故事。

同時為了增加一些深度,他加入了三個帶有發光護身符的孩子的鏡頭,暗示了更深層次的故事情節。

第二步是在 Midjourney 中生成連續的圖像。

這裡要特別注意提示詞(prompt)。Neubert 對自己在以往帖子中獲得的穩定提示詞進行了最佳化,創建了一個範本,這樣在預告片的每個鏡頭中都能重複使用它。範本如下:

___________,星際大戰、風格為精細的人群場景、樸實的自然主義、青色和黃色、寒霜龐克、室內場景、cinestill 50d—ar 21:9— 原始風格

對於每個場景,他都會用自己想要的場景來填補空白,確保其他 tokens 最大限度地保持主題、顏色和照明的連貫性。

此外利用強變化(Strong Variations)功能,使得更容易創建不同的場景,同時保留之前的調色板。女戰士的場景可以轉變為普通公民、網路駭客或戰鬥的場景,無需產生新的提示詞。

第三步是在 Runway 中生成動畫圖像。

Neubert 發現這一步是最簡單的。在設定上,他總是嘗試啟動放大(Upscaled)模式。不過該模式常常遇到臉部問題,所以針對人物鏡頭,他通常使用標準品質。

值得注意的是,他沒有使用文字提示詞與圖像提示詞相結合的方式,而是拖放一張圖像並重新繪製它,直到得到自己滿意的結果。

最後一步是在 CapCut 後期剪輯。

在 Midjourney 和 Runway 生成輸出的同時,Neubert 首先放置自己知道將發揮重要作用的關鍵場景。就預告片而言,他認為外景鏡頭將成為開場。

接著開始計畫文本。當根據音樂來定位文本時,時間軸中沒有任何剪輯,這是有可能的。他在不到一個小時的時間裡就按照時間線編好了內容並定了位。這對生成圖像很有説明,你需要一個額外的固定點來考慮仍然缺少了哪些場景。

具體的步驟變得很簡單,生成剪輯→ 將它們拉入 CapCut → 放置在時間軸上,然後慢慢拼湊故事。他還對 2 到 3 個編輯包進行了顏色匹配,讓它們看起來更像宏大的電影場景。

使用 CapCut 唯一需要的技巧是對剪輯進行節拍的同步。當音樂中出現「BWAAA」時,他總是嘗試連接剪輯內的動作或者排列後面的剪輯。這會令整個序列更有身臨其境的感覺。

此外 Neubert 還考慮了如何在剪輯中加入大量的動作。這裡他使用了兩個技巧來增加動作。

第一個技巧:Runway 會接收一張圖像,然後根據模型運算哪些部分應該進行動畫處理。他對這個想法進行了逆向工程,嘗試在 Midjourney 中輸出暗示運動的圖像。這意味著可以在鏡頭中加入運動模糊或者可以捕捉移動頭部或人物的靜止圖像。

第二個技巧:當你分析 Runway 影片時會發現在 4 秒剪輯中,場景經常發生很大的變化。因此在預告片場景中,他只使用了完整的 4 秒剪輯兩次。所有其他剪輯的長度均為 0.5-2 秒,並將剪輯的速度提高了 1.5- 3 倍。這樣做的原因是,作為觀看者,你只能看到時間很短的剪輯,因而會在場景中感知到更多運動,本質上是快進了該部分。

一番操作下來,最終呈現出給大家的就是開頭的那個震撼的《創世紀》預告片。該預告片也得到盛讚,有人表示,這是自己至今為止看過的最好的 Runway 生成影片。

其實,在 Runway Gen-2 可以免費試用後,不少網友大開腦洞,將它與 Midjourney 結合起來,大膽創作。

Midjourney+Runway:神奇的 AI 創作工具組合

這裡與大家分享一些其他的生成範例。

Runway 對與人物動作細節的把握也是較為準確的。在網友申城的影片中可以看到,人物眼睛的細節讓動態影片更加傳神,也可以說了平添了幾分「演技」。

圖片動起來之後,人與馬在夜色中的動作十分自然,對於人物,甚至後續動作的想像空間也有了更大留白。

Midjourney 與 Runway 的組合看起來很是無敵,在人物關鍵動作上能刻畫出適當的故事感。

還有一些變化更加豐富,也更具創意的生成結果。

也有網友利用一系列 AI 工具生成影片短片,可是結果似乎不盡人意。

Twitter使用者 @nickfloats 使用 ChatGPT 撰寫腳本、Midjourney 生成圖像、Runway 生成影片、Triniti 生成音樂、Eleven Labs AI 配音,剪輯就將其簡單的拼接在一起,不做其他調整。

網友記錄了自己製作的全過程,想看看全程使用 AI 製作廣告短片需要多久。

在經過 45 分鐘之後,成片出來了,它的效果如何?

這名網友對這個短片成果的評價是 「The ad sucks」。這廣告中,人物的動作僵硬,畫面的邏輯關係不強,整體也很難凸顯出想要表達的主題。AI 的通力合作似乎並沒有出現驚喜,反而是「驚嚇」更多一些。

與《創世紀》相比,這個廣告短片時長是它的一半,但是用時極少。其中最大的差異就是人類參與的細節。它沒有仔細斟酌後的主題、追求連貫的不斷調整以及對細節的高要求。

如果只讓 AI 來參與,或是只根據 AI 的生成來產出作品,顯然還不能夠由高品質的成果。人類對它們的應用和調整似乎才能體現這些工具的真正價值。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!