ADVERTISEMENT

作為生成式AI、圖形顯示和元宇宙基礎設施領域的「狠角色」,全球AI晶片霸主NVIDIA接下來會放出哪些重磅「核彈」,已經預定了科技圈的焦點。

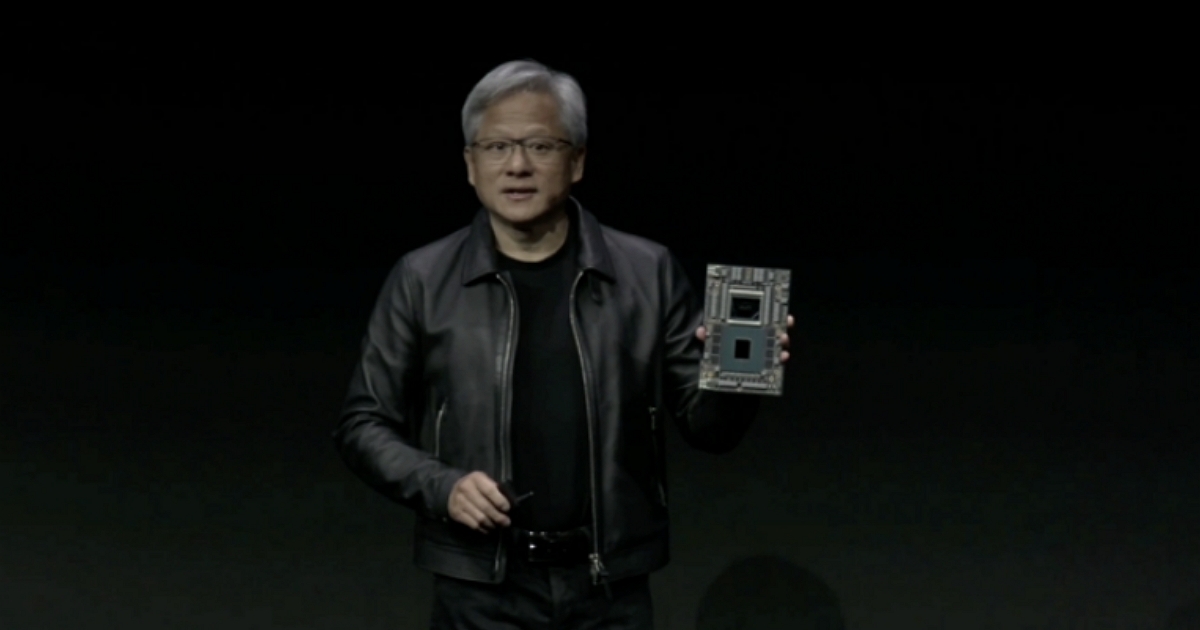

在電腦圖形年會SIGGRAPH上,NVIDIA創始人兼CEO黃仁勳一如既往穿著經典的皮衣登場,並一連亮出多款硬體。

在黃仁勳眼中,生成式AI是AI的「iPhone時刻」。他表示,人類的自然語言將成為新的程式語言,我們已經使電腦科學民主化,現在每個人都可以成為程式設計師。

在隨後大約1小時20分鐘的演講中,黃仁勳宣佈全球首發HBM3e記憶體——推出下一代GH200 Grace Hopper超級晶片。黃仁勳將它稱作「加速運算和生成式AI時代的處理器」。

配備全球最快記憶體的超級晶片來了!降低大模型推理成本

全球第一款HBM3e GPU終於來了!

黃仁勳宣佈推出針對加速運算和生成式AI的新一代NVIDIA GH200 Grace Hopper超級晶片。

GH200由72核Grace CPU和4PFLOPS Hopper GPU組成,在全球最快記憶體HBM3e的「助攻」下,記憶體容量高達141GB,提供每秒5TB的頻寬。 其每個GPU的容量達到NVIDIA H100 GPU的1.7倍,頻寬達到H100的1.55倍。

該超級晶片可以用於任何大型語言模型,降低推理成本。

與當前一代產品相比,新的雙GH200系統共有144個Grace CPU核心、8PFLOPS運算性能的GPU、282GBHBM3e記憶體,記憶體容量達3.5倍,頻寬達3倍。如果將連接到CPU的LPDDR記憶體包括在內,那麼總共內建了1.2TB超快記憶體。

GH200將在新的伺服器設計中提供,黃仁勳還放出了一段動畫影像,展示組裝面向生成式AI時代的Grace Hopper AI超級電腦的完整過程。

首先是一塊Grace Hopper,用高速互連的CPU-GPU Link將CPU和GPU「黏」在一起,通訊速率比PCIe Gen5快7倍。

一個Grace Hopper機架裝上NVIDIA BlueField-3和ConnectX-7網路卡、8通道4.6TB高速記憶體,用NVLink Switch實現GPU之間的高速通訊,再加上NVLink Cable Cartridge,組成了NVIDA DGX GH200建構塊。

NVIDA DGX GH200由16個Grace Hopper機架,透過NVLink Switch系統連成叢集,能讓256塊GPU組成的系統像一塊巨型GPU一樣工作。 由256塊GH200組成的NVIDIA DGX GH200 SuperPod,擁有高達1EFLOPS的算力和144TB高速記憶體。

NVIDIA Quantum-2 InfiniBand Switch可用高速、低延遲的網路連線多個DGX SuperPod,進而搭建出面向生成式AI時代的Grace Hopper AI超級電腦。

這帶來的主要優勢是,實現同等算力的情況下,用更少卡、省更多電、花更少錢。

黃仁勳拋出一個問題:花1億美元能買什麼?

過去,1億美元能買8800張x86 CPU組成的資料中心,功耗是5MW。

如今,1億美元能買2500張GH200組成的Iso-Budget資料中心,功耗是3MW,AI推理性能達到上述CPU系統的12倍,能效達20倍。

如果達到跟x86 CPU資料中心相同的AI推理性能,Iso-Troughput資料中心只需用到210塊GH200,功耗是0.26MW,成本只有CPU資料中心的1/12,僅800萬美元。

「買得越多,省得越多。」黃仁勳再度用這句講過很多遍的「導購金句」總結。

為方便GH200應用,GH200與今年早些時候在COMPUTEX上推出的NVIDIA MGX伺服器規範完全相容。因此系統製造商可以快速且經濟高效地將GH200新增到其伺服器版本中。

新GH200預計將於明年Q2投入生產。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!