ADVERTISEMENT

「分割一切」這件事,又有一項重量級研究出現了。

香港中文大學終身教授賈佳亞團隊,最新提出LISA大模型——理解人話,精準分割。

例如讓AI看一張早餐圖,要辨識「哪個是柳丁」是比較容易的,但若是問一句「哪個食物維他命C最高」呢?

畢竟這不是一個簡單分割的任務了,而是需要先認清圖中的每個食物,還要對它們的成分有所瞭解。

但現在,對於這種人類複雜的自然語言指令,AI已經是沒有在怕的了,來看下LISA的表現:

結果,LISA精準無誤的將橘子分割了出來。

再「餵」給LISA一張圖並提問:

是什麼讓這位女士站的更高?請把它分割出來並解釋原因。

LISA不僅辨識出來了「梯子」,而且也對問題做出了解釋。

還有一個更有意思的例子。

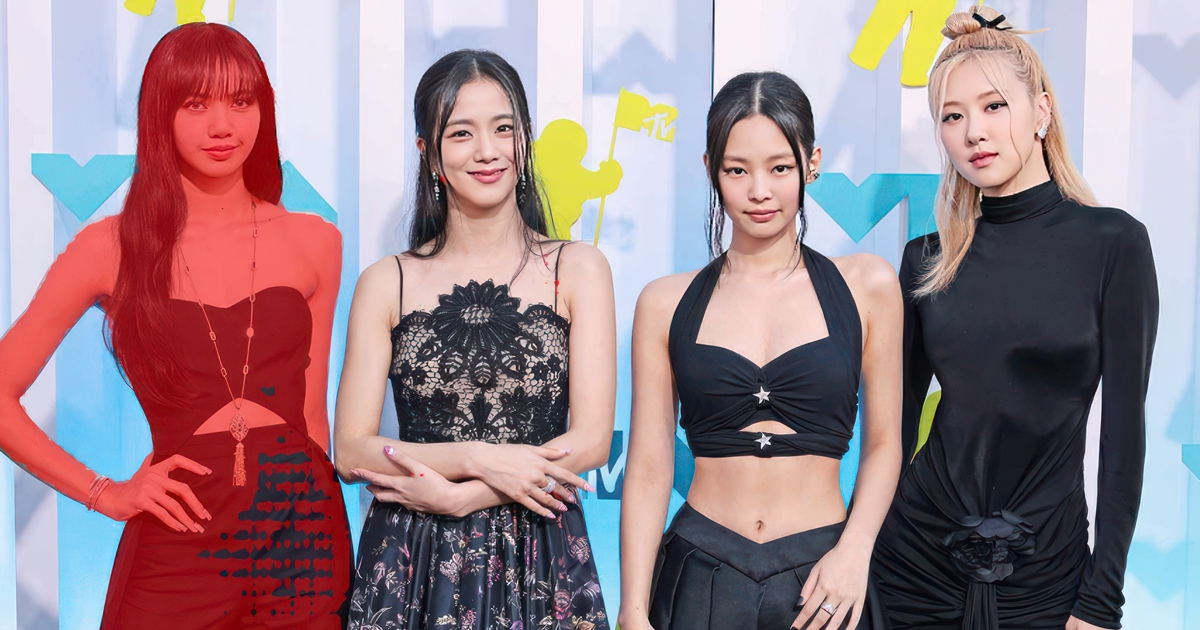

許多朋友在看到這個大模型的名字,或許會聯想到女子組合BLACK PINK裡的Lisa。

賈佳亞團隊還真的拿她們的照片做了個測試——讓LISA找Lisa:

真的很會玩!

基於LISA,複雜分割任務拿下SOTA

根據發表的論文來看,LISA是一個多模態大模型,它在這次研究中主攻的任務便是推理分割(Reasoning Segmentation)。

這個任務要求模型能夠處理複雜的自然語言指令,並給出精細的分割結果。

如上圖所示,推理分割任務具有很大的挑戰性,可能需要借鑒世界知識(例如,左圖需要瞭解「短鏡頭更適合拍攝近物體」),或進行複雜圖文推理(如右圖需要分析圖像和文本語義,才能理解圖中「柵欄保護嬰兒」的含義),才能獲得最終理想的分割結果。

儘管當前多模態大模型(例如Flamingo[1], BLIP-2[2], LLaVA[3], miniGPT-4[4], Otter[5])使得AI能夠根據圖像內容推理使用者的複雜問題,並給出相應的文本分析和回答,但仍無法像視覺感知系統那樣在圖像上精確定位指令對應的目的地區域。

因此,LISA透過引入一個<SEG>標記來擴展初始大型模型的詞彙表,並採用Embedding-as-Mask的方式賦予現有多模態大型模型分割功能,最終展現出強大的零樣本泛化能力。

同時,這項工作還創建了ReasonSeg資料集,其中包含上千張高品質圖像及相應的推理指令和分割標注。

那麼LISA這種精準理解人話的分割能力,具體是怎麼做到的呢?

首先將圖像ximg和文本xtxt送到多模態-大語言模型F(在實驗中即LLaVA),得到輸出的文本結果,如果此時文本結果包含<SEG>標記,則表示需要通過輸出分割預測來解決當前問題。反之,若不包含<SEG>標記,則無分割結果輸出。

如果存在標記,則將<SEG>標記在多模態大模型F最後一層對應的embedding經過一個MLP層得到hseg,並將其與分割視覺特徵f一起傳遞給解碼器Fdec(其中分割視覺特徵f由輸入編碼器Fenc對圖像ximg進行編碼得到)。

最終,Fdec根據生成最終的分割結果M。

LISA在訓練過程中使用了自回歸交叉熵損失函數,以及對分割結果監督的BCE和DICE損失函數。

實驗證明,在訓練過程中僅使用不包含複雜推理的分割資料(透過將現有的語義分割資料如ADE20K[6],COCO-Stuff[7]以及現有指代分割資料refCOCO系列[8]中的每條資料轉換成「圖像-指令-分割Mask」三元組) ,LISA能在推理分割任務上展現出優異的零樣本泛化能力。

此外,進一步使用239個推理分割資料進行微調訓練還能顯著提升LISA在推理分割任務上的性能。而且LISA還表現出高效的訓練特性,只需在8張具有24GB顯存的3090顯卡上進行10,000次訓練反覆運算,即可完成7B模型的訓練。

最終,LISA不僅在傳統的語言-圖像分割指標(refCOCO、refCOCO+和refCOCOg)上展現出優異性能,還能處理以下分割任務情景:⑴複雜推理;⑵聯繫世界知識;⑶解釋分割結果以及⑷多輪對話。

在有複雜情景的ReasonSeg資料集上,LISA顯著領先於其他相關工作,進一步證明其出色的推理分割能力。

線上可試玩

值得一提的是,LISA的推理分割能力已經出了demo,可以線上體驗。

操作也很簡單,只需填寫「指令」,然後上傳要處理的圖像即可。

若是不會描述指令,Demo下方也給出了一些示例,也可以參考。

- GitHub連結:https://github.com/dvlab-research/LISA

- 論文連結:LISA:REASONINGSEGMENTATIONVIALARGE LANGUAGEMODEL

- Demo連結:LISA: Reasoning Segmentation via Large Language Model

參考連結:

- Alayrac, Jean-Baptiste, et al. 「Flamingo: a visual language model for few-shot learning.」 In NeurIPS, 2022.

- Li, Junnan, et al. 「Blip-2: Bootstrapping language-image pre-training with frozen image encoders and large language models.」 In arXiv preprint, 2023.

- Liu, Haotian, et al. 「Visual instruction tuning.」 In arXiv preprint, 2023.

- Zhu, Deyao, et al. 「Minigpt-4: Enhancing vision-language understanding with advanced large language models.」 In arXiv preprint, 2023.

- Li, Bo, et al. 「Otter: A multi-modal model with in-context instruction tuning.」 In arXiv preprint, 2023.

- Zhou, Bolei, et al. 「Scene parsing through ade20k dataset.」 In CVPR, 2017.

- Caesar, Holger, Jasper Uijlings, and Vittorio Ferrari. 「Coco-stuff: Thing and stuff classes in context.」 In CVPR, 2018.

- Kazemzadeh, Sahar, et al. 「Referitgame: Referring to objects in photographs of natural scenes.」 In EMNLP, 2014.

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!