ADVERTISEMENT

你相嗎信?大貓熊都會打撲克牌了!

看這毛茸茸的腦袋、抓牌的動作……而這其實都是AI生成的,而且還不用樣本。

這就是Google最新大語言模型VideoPoet。

它不僅沒有用影片領域常用的擴散模型,還零樣本實現了SOTA。相較於此前一些模型,畫面更加穩定、動作更加逼真,清晰度也直線up。

和Bard合作一下,就能輕鬆搞定1分鐘長的短片,從腳本到畫面全部不用人類插手。

這效果,讓網友們直呼:影片生成進化速度也太快了吧。不少人都表示想玩!有人還說,VideoPoet效果這麼好,看來Runway和Pika要加速了!

畫面逼真動作穩定

具體來看VideoPoet的能力非常全面。包括:

- 文字-影片

- 圖像-影片

- 影片編輯

- 風格化處理

- 畫面補充

文字到影片任務,影片輸出長度可調整,而且可以基於文字內容應用一系列動作和風格。

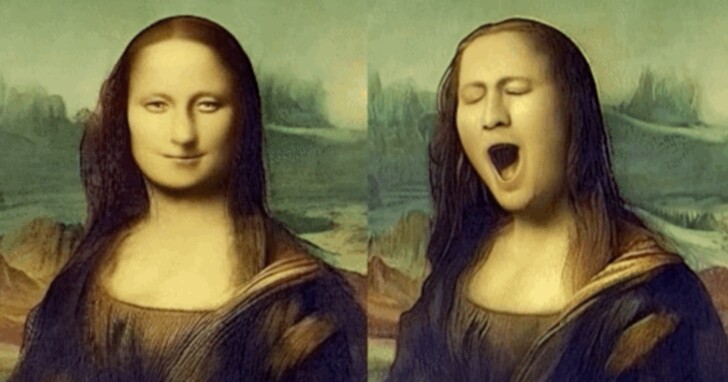

圖像到影片任務,則能讓靜態圖片動起來。例如一些世界名畫和照片,都可製作成影片。

同時也能調整影片風格,需要額外輸入一些文字,然後模型會預測影片的光照和深度資訊。

例如輸入「鐵獅子在熔爐的火光中咆哮」,原本無厘頭的太陽花獅子就變得兇猛威嚴起來。

當然也能進行影片編輯,像是讓影片中的機器人隨意運動、背景中加上煙霧等,都是輸入文字指令即可實現。

或者是輸入圖像,然後修改它的動作。讓蒙娜麗莎轉動身體、打哈欠。

以及可調整鏡頭動作。基本的縮放、弧線、航拍鏡頭都可搞定。

如果想讓擴充影片畫面、增加影片元素,VideoPoet也能辦到。

值得一提的是,VideoPoet還可以根據影片配樂。 這也是讓不少網友感到驚訝的地方。

例如先讓VideoPoet產生一段小熊打爵士鼓的影片,然後不給它任何文字提示,VideoPoet根據畫面內容自己生成了配樂。

如果想要生成更長的影片,可以透過輸入影片的最後一秒畫面讓VideoPoet預測下一段影片,反復多次即可實現。

如下案例時長約為10秒。

用LLM零樣本生成影片

不僅是生成效果好,VideoPoet還有一個優勢在於,以LLM為基礎,它能更方便利用現有大模型進行改進。

例如VideoPoet就使用了T5的編碼器。

不過由於大語言模型使用離散token,使得它生成影片具有一定挑戰性。 與自然語言不同,人類對視覺世界尚未演化出最佳的詞彙表達。 透過影片/音訊tokenizer可以來克服這一問題。它們能將影片和音訊編碼為離散token,也可將其轉換為原始表示。VideoPoet正是基於這一原理實現。

它利用MAGVIT V2來搞定影片圖像表示,SoundStream搞定音訊表示。前者是GoogleCMU團隊在今年10月提出的方法,該方法實現了語言模型首次在ImageNet基準上擊敗擴散模型。後者是一個端到端神經音訊解碼器。

具體來看VideoPoet的框架。它支援文字、視覺、音訊輸入,分別可利用t5、MAGVIT V2、SoundStream的編碼器。然後再自回歸生成輸出。

實驗結果方面,在提示詞與生成結果的吻合度方面,VideoPoet超過多個擴散模型。

生成動作方面的優勢更加明顯。

這項工作由Google研究帶來,作者是兩位軟體工程師Dan Kondratyuk和David Ross。據Dan透露,VideoPoet的論文也會馬上上線。

參考連結:

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!