ADVERTISEMENT

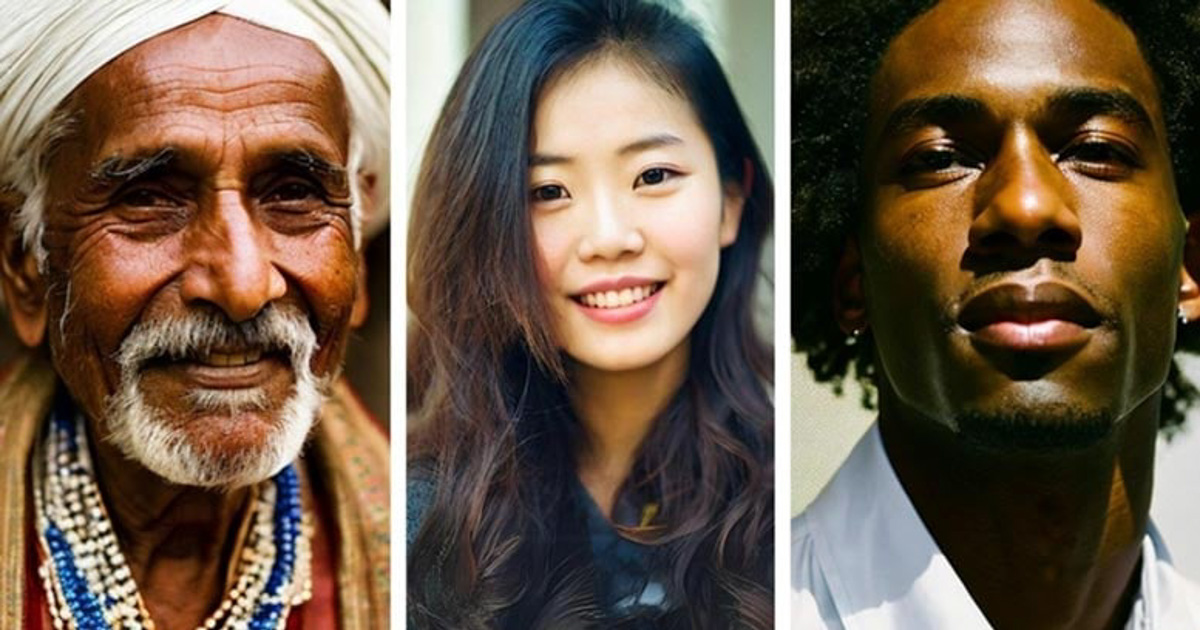

如果你最近在辨別一個人的圖像是真實的還是人工智慧(AI)生成的過程中遇到困難,那麼你並不孤單。研究表明,調查參與者被人工智慧生成的圖像欺騙的比例接近 40%。

滑鐵盧大學研究人員的一項新研究發現,人們比預期更難區分誰是真人,誰是人工生成的。

滑鐵盧大學的研究為 260 名參與者提供了 20 張沒有標籤的圖片:其中 10 幅是透過 Google 搜尋獲得的真人圖片,另外 10 幅則是由穩定擴散或 DALL-E 這兩種常用的人工智慧程式生成的圖片。

研究人員要求參與者給每張圖片貼上真實或人工智慧生成的標籤,並解釋他們做出這一決定的原因。只有 61% 的參與者能分辨出人工智慧生成的人和真實的人,遠遠低於研究人員預期的 85% 臨界值。

誤導性指標與人工智慧的快速發展

滑鐵盧大學電腦科學博士候選人、本研究的第一作者 Andreea Pocol 說:「人們並不像自己認為的那樣善於區分。」

參與者在尋找人工智慧生成的內容時,會注意手指、牙齒和眼睛等細節,將其作為可能的指標,但他們的評估並不總是正確的。

Pocol 指出,這項研究的性質允許參與者長時間仔細觀察照片,而大多數 Internet 使用者只是順便看看圖片,不會注意到這些提示。

人工智慧技術的發展速度極快,這使得理解人工智慧生成的圖像可能帶來的惡意或邪惡行為變得尤為困難。學術研究和立法的步伐往往跟不上:自 2022 年底研究開始以來,人工智慧生成的圖像變得更加逼真。

人工智慧生成虛假資訊的威脅

作為一種政治和文化工具時,這些人工智慧生成的圖像尤其具有威脅性,任何使用者都可以透過它製作出公眾人物處於尷尬或危險境地的假圖像。

Pocol 說:「虛假資訊並不新鮮,但虛假資訊的工具一直在不斷變化和發展。可能到了這樣一個地步,無論人們接受過怎樣的培訓,他們仍然難以區分真實圖像和假圖像。這就是為什麼我們需要開發工具來辨識和應對這種情況。這就像是一場新的人工智慧軍備競賽。」

這項名為「眼見為實」的研究發表在《電腦圖形學進展》(Advanced Computer Graphics)雜誌上:Deepfakes, AI-Generated Humans, and Other Nonveridical Media: A Survey on the State of Deepfakes, AI-Generated Humans, and Other Nonveridical Media》一文發表在《電腦圖形學進展》(Advances in Computer Graphics)雜誌上。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!