ADVERTISEMENT

AMD在消費級AI效能說明會中,展示自家處理器產品在執行Llama 2與Mistral等大型語言模型的效能領先Intel Core Ultra最高達17%。

離線執行好處多多

大型語言模型(Large Langue Model,以下簡稱LLM)是現在相當熱門的生成式AI應用,使用者可以直接與系統透過自然語言的文字溝通,詢問並得到有參考價值的回達。其中以程式編譯為主要應用領域的Llama Code,甚至可以在分析使用者的需求描述之後,生成對應的程式碼。

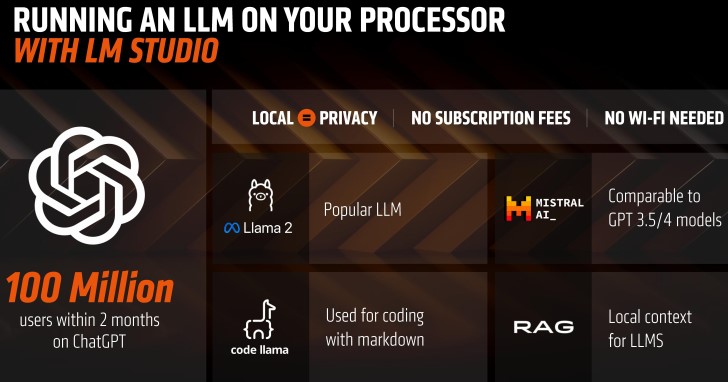

雖然目前有許多雲端版本的LLM服務,使用者可以直接透過瀏覽器進入操作介面,快速享受LLM的便利,但是這類服務大多需要收費,使用時也需要連接至網路。

AMD在官方部落格推薦LM Studio軟體套件,使用者可以輕鬆將LLM安裝至自己的電腦並在離線狀態下使用,這樣的好處除了不需支付使用費,而且可以在沒有網路的情況下使用之外,更重要的是所有資料都是在本機電腦處理,不需上傳至雲端,所以不用擔心資料外洩的風險,對於處理機敏資料或是生成公司使用的程式碼時格外重要。

▲AMD提供透過AI在Unity撰寫彈跳球體程式碼的範例展示。

提供領先的筆電LLM效能

以AMD Ryzen 7840U處理器為例,它具有CPU(中央處理器)、GPU(繪圖處理器)、NPU(神經處理器)等不同運算單元,CPU除了能夠進行一般通用型運算之外,也透過AVX-512以及VNNI等指令集來強化AI運算的效能表現。

GPU的主要工作雖然是繪製3D圖像,但是因為其架構的特性,也很適合用於加速AI運算,而NPU則是專為AI運算設計的加速運算單元,內建於部分Ryzen 7000與8000系列。活用這3種不同的運算單元,將可提升多種AI運算負載的效能表現。

根據AMD提供的數據,在使用搭載AMD Ryzen 7840U的HP Pavilion Plus以及搭載Intel Core Ultra 7 155H的Acer Swift SFG14-72T等筆記型電腦時,在執行Llama 2與Mistral的效能表現最高可領先14%與17%,而在產生第1個Token(可以粗淺理解為辭彙)的速度則最多快了79與41%。

需要注意的是,Ryzen 7840U的TDP僅為15W,大約僅為Core Ultra 7 155H 28W的一半,這代表的是在執行AI運算的過程中,Ryzen 7840U所消耗的電力更少,有助於提供更長的電池續航力,延伸AI運算的使用時間並避免電力耗盡。

▲從實際影片中可以看到,右側的AMD平台產生回應的速度明顯比較流暢。

由於LM Studio軟體套件對系統需求篇低,有興趣的讀者可以在自己的電腦安裝並進行嘗試。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!