ADVERTISEMENT

集邦諮詢報告稱,隨著AI伺服器算力、功耗同步與日俱增,尤其是NVIDIA將在年底推出的下一代Blackwell平台功耗急劇增加,液冷散熱方案將逐漸普及,今年底的滲透率可達10%。

根據調查,NVIDIA Blackwell要到2025年才會正式大規模放量,取代現在的Hopper平台,成為高階主力,佔整體高階產品的近83%。

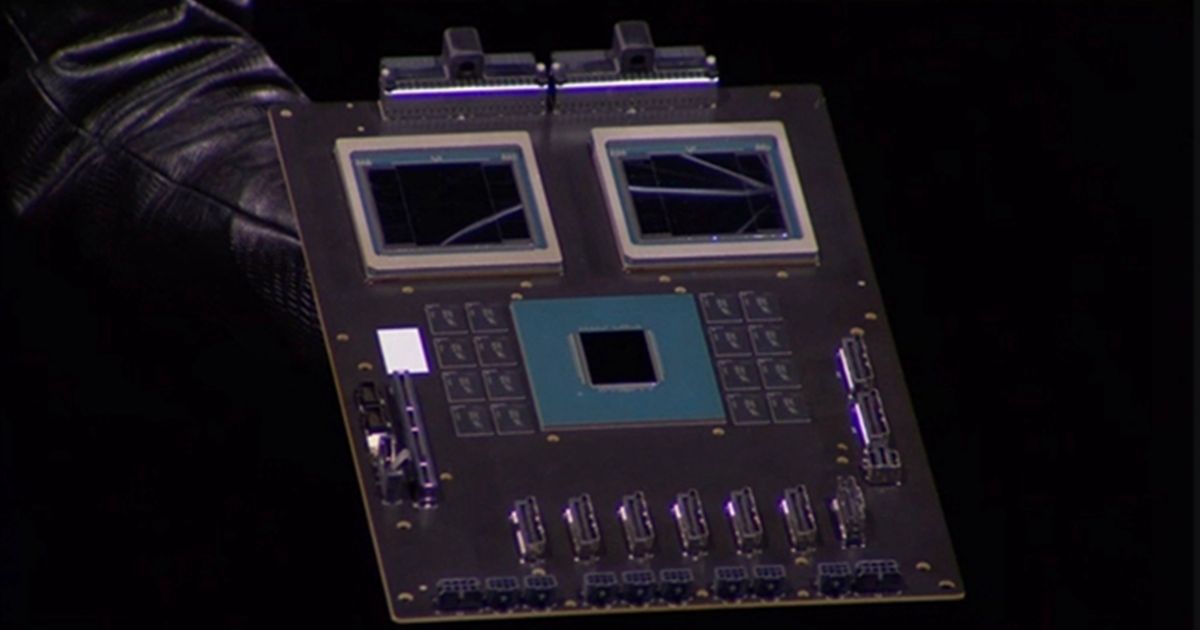

Blackwell B200單顆晶片的功耗就高達1000W,一顆Grace CPU和兩顆Blackwell GPU組成的超級晶片GB200更是達到2700W。回顧歷史,Hopper家族的H100、H200 GPU功耗都是700W,H20隻需要400W,Grace+Hopper超級晶片則是1000W。

NVIDIA HGX伺服器每台預裝8顆GPU,NVL36、NVL72伺服器每台36顆、72顆GPU,整體功耗將分別達到70千瓦、140千瓦。

據悉,NVL36伺服器2024年底先上市,初期以風冷、液冷平行方案為主;NVL72 2025年跟進,直接優先上液冷,整體設計和散熱都複雜得多。

NVIDIA預計,GB200折算NVL36的出貨量在2025年預計可達6萬台,Blackwell GPU的總出貨量有望達到210-220萬顆。

伺服器液冷主要分為水冷板(Cold Plate)、冷卻分配系統(Coolant Distribution Unit, CDU)、分歧管(Manifold)、快接頭(Quick Disconnect, QD)、風扇背門(Rear Door Heat Exchanger, RDHx)等五大元件。

其中,CDU是最關鍵的部分,負責在整個系統內調節冷夜的流量,確保溫度可控。

針對NVIDIA AI伺服器方案,維諦技術(Vertiv)是主力的CDU供應商,奇鋐、雙鴻、台達電、CoolIT等也在測試驗證。

- 延伸閱讀:Supermicro 推出支援 NVIDIA Blackwell 和 NVIDIA HGX H100/H200 的機櫃級隨插即用液冷 AI SuperCluster

- 延伸閱讀:Supermicro宣布X13機櫃氣冷、液冷解決方案,支援最新第五代Intel Xeon處理器

- 延伸閱讀:全球首款浸没式液冷 SSD 建興儲存科技鎖定 AI 運算資料中心

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!