ADVERTISEMENT

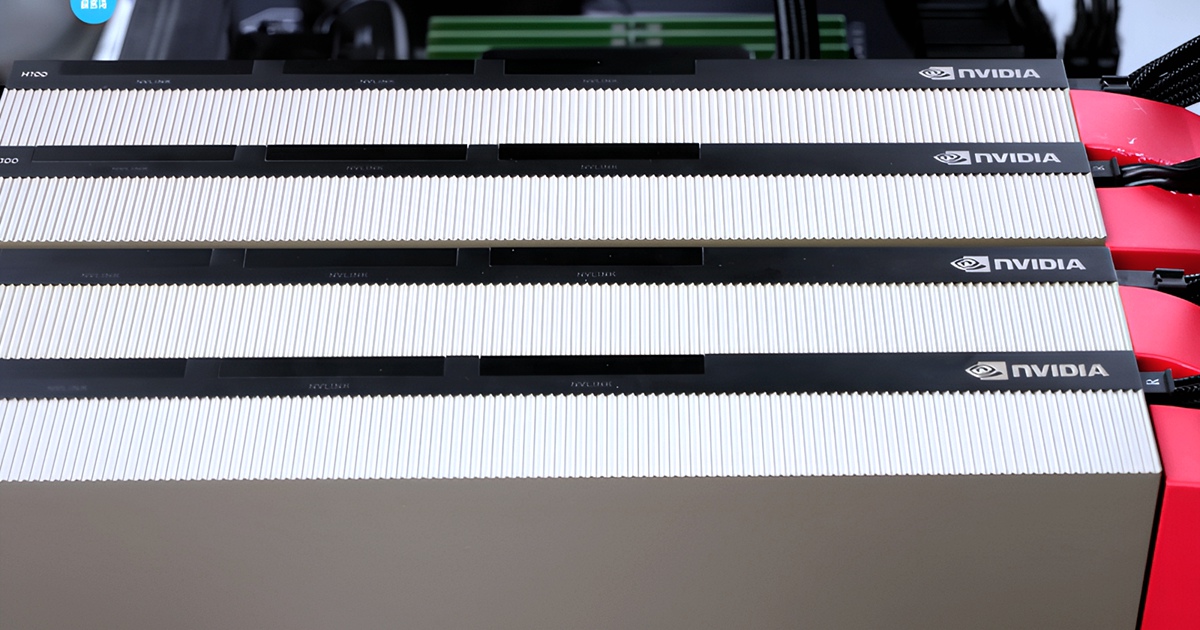

馬克·祖克柏在本週稍早的 Meta 財報電話會議上表示,該公司正在「一個超過 10 萬個 H100 AI GPU 的伺服器機群上」訓練 Llama 4 模型,「比我所見過的任何報導中提到的其他公司規模都大」。雖然這位 Facebook 創始人沒有透露 Llama 4 可以做些什麼的任何細節,但《Wired》雜誌援引祖克柏的話稱,Llama 4 具有「新的模態」、「更強的推理能力」和「更快的速度」。這是一個至關重要的發展,因為 Meta 正在與微軟、谷歌和馬斯克的 xAI 等其他科技巨頭競爭,以開發下一代 AI 大型語言模型。

Meta 並不是第一家擁有 10 萬個 Nvidia H100 GPU 的 AI 訓練伺服器機群的公司。伊隆·馬斯克在 7 月下旬啟動了一個規模類似的伺服器機群,稱其為「超級運算工廠」,並計劃將其規模擴大一倍,達到 20 萬個 AI GPU。然而,Meta 今年早些時候曾表示,預計到 2024 年底將擁有超過 50 萬個 H100 等效的 AI GPU,因此它可能已經有大量的 AI GPU 在運行以訓練 Llama 4。

Meta 的 Llama 4 採用了一種獨特的 AI 開發方法,因為它完全免費開放其 Llama 模型,允許其他研究人員、公司和組織在其基礎上進行構建。這與 OpenAI 的 GPT-4 和谷歌的 Gemini 等其他模型不同,後者只能透過 API 存取。然而,該公司仍然對 Llama 的授權施加了限制,例如限制其商業用途,並且不提供有關其訓練方式的任何訊息。儘管如此,它的「開源」性質可能有助於它主導 AI 的未來 —— 我們已經從基於開源代碼構建的中國 AI 模型中看到了這一點,這些模型在基準測試中可以與 GPT-4 和 Llama-3 相媲美。

功耗問題

所有這些運算能力都會導致巨大的電力需求,尤其是一張現代 AI GPU 每年可能消耗高達 3.7 兆瓦時的電力。這意味著一個 10 萬個 AI GPU 的伺服器機群每年將至少使用 370 千兆瓦時 —— 足以供 3400 萬個普通美國家庭使用。這引發了人們對這些公司如何找到如此龐大的電力供應的擔憂,尤其是因為新的電力來源上線需要時間。畢竟,就連祖克柏本人也表示,電力限制將限制 AI 的增長。

例如,伊隆·馬斯克使用幾個大型行動發電機為他在孟菲斯的 10 萬個強大的運算伺服器機群供電。谷歌一直未能實現其碳排放目標,自 2019 年以來,其溫室氣體排放量增加了 48%。就連前谷歌首席執行長也建議我們應該放棄我們的氣候目標,讓 AI 公司全力以赴,然後使用我們開發的 AI 技術來解決氣候危機。

然而,當一位分析師詢問 Meta 公司如何為如此龐大的運算伺服器機群供電時,Meta 的高階主管們迴避了這個問題。另一方面,Meta 的 AI 競爭對手,如微軟、谷歌、甲骨文和亞馬遜,正紛紛加入核能的行列。他們要嘛投資於小型模組化反應爐,要嘛重啟舊的核電站,以確保他們有足夠的電力來支持他們未來的發展。

雖然這些都需要時間來開發和部署,但為 AI 數據中心提供他們自己的小型核電站將有助於減輕這些耗電的伺服器機群對國家電網的負擔。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!