ADVERTISEMENT

繼先前NVIDIA發表將CUDA帶進Arm架構處理器的超級電腦後,在2019年Supercomputing超級運算大會上,發表了能讓繪圖處理器繞過處理器,直接存取記憶體資料的Magnum IO軟體套件,能夠有效降低運算過程中的延遲,大幅提升整體效能表現。

打通AI運算任督二脈

由於AI運算與一般運算的特性有所不同,所以往往對繪圖處理器(GPU)的資源需求高於處理器(CPU),而且運算過程需要存取大量資料,造成建置電腦時所需要的繪圖處理器數量會高於處理器,且許多運算時間會浪費在繪圖處理器存取記憶體的延遲。

先前NVIDIA在2019年國際超級運算大會(International Supercomputing Conference)發表了CUDA on Arm,讓採用Arm架構處理器建置的超級電腦也能使用NVIDIA繪圖處理器進行高效能運算(High Performance Computing,以下簡稱HPC),並預計在2019年底達到支援600款HPC運算軟體與全部AI框架的目標,其中也支援NVIDIA的CUDA-X AI與HPC函數庫。

如此一來無論處理器的架構為Arm、Power、x86的電腦,都能透過NVIDIA繪圖處理器為AI運算加速,讓使用者可以選擇適合自身使用情境的處理器,例如利用Arm架構處理器追求更高的電力效率。

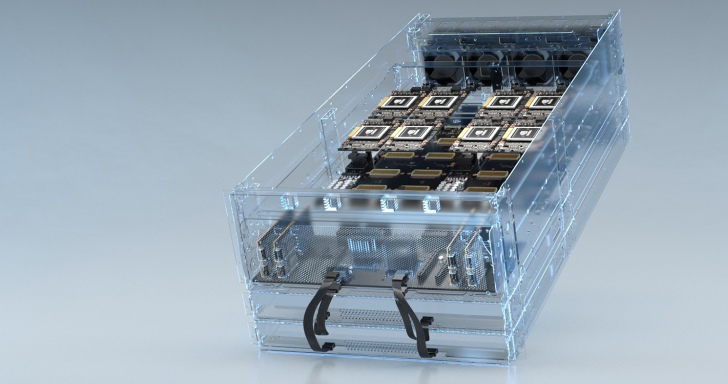

而在2019年Supercomputing超級運算大會上,NVIDIA進一步宣佈Magnum IO軟體套件,可以透過最佳化方式消除儲存、I/O造成的效能瓶頸。根據官方提供的說明,能提升多伺服器、多繪圖處理器的運算節點在處理複雜金融分析、氣候預測時資料處理效能達20倍之譜,讓資料科學家與AI、HPC研究員在數分鐘內完成原本需要花費數小時的工作。

與Microsoft共推雲端運算

企業除了可以自行架設伺服器外,Microsoft全新的Azure NDv2系列虛擬機器最多能在單個Mellanox InfiniBand後端網路提供高達800個的NVIDIA Tesla V100繪圖處理器,加快企業部署AI運算的速度。

如此一來企業只需在自己的辦公室租用虛擬機器,並在短短幾個小時內完成過去需要花費數月的AI運算超級電腦部署工作,大大降低時間成本。

對此NVIDIA副總裁兼加速運算總經理Ian Buck說:「相較於先前只有世界級的大企業與組織能擁有AI與HPC運算的超級電腦,但Microsoft Azure新產品的催化讓AI變的更加民主化(Microsoft Azure’s new offering democratizes AI),讓人們能有更多工具能解決各項重大挑戰。」

(圖片說明文字)

Magnum IO的主要功能在「將」低繪圖處理器存取資料的延遲與處理器占用率 將 > 降

> 而且「需要」運算過程需要存取大量資料 需要 >(贅字)

>

> (圖片說明文字)

> Magnum IO的主要功能在「將」低繪圖處理器存取資料的延遲與處理器占用率 將 > 降

>

感謝提醒,已修正