ADVERTISEMENT

NVIDIA在SC20(2020年超級電腦大會)發表了A100 80GB GPU、DGX A100 640GB與DGX Station A100運算平台、Mellanox NDR 400G InfiniBand等產品,為以GPU為基礎的超級電腦帶來更強大的運算效能。

A100記憶體加1倍

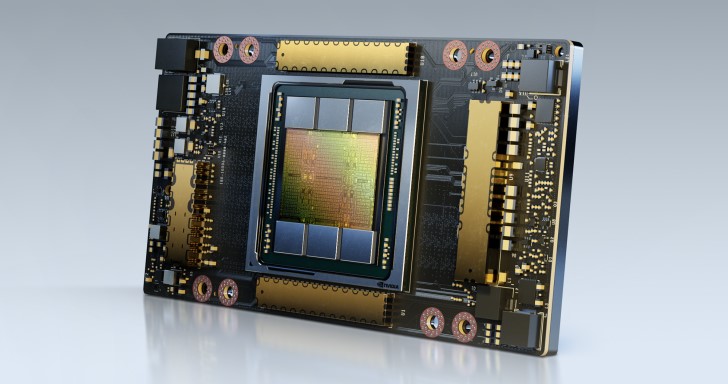

先前NVIDIA推出搭載A100 GPU(繪圖處理器,此處用於AI運算)的DGX A100運算平台,當時每個A100僅搭載40GB記憶體,而這次NVIDIA推出記憶體容量翻倍的80GB版本。

A100 80GB搭載HBM2e類型記憶體,頻寬高達2TB/s,不但可以透過更高的頻寬快速匯入更多資料,更大的容量也有助於處理更龐大的模型與資料集,加速研究人員進行AI運算或模擬的流程。

根據NVIDIA官方提供的參考資料,在DLRM這類含有大量表格以記載數十億名使用者與十億項產品的推薦系統模型的AI訓練過程中,A100 80GB能提供3倍的加速效果,讓企業能在同樣的時間中進行更多訓練,以提高模型的精準度。另外由於A100 80GB能夠訓練更龐大的模型,因此不再需要耗費大量時間建置資料或模型平行處理架構,並避免跨多個節點運算所造成的效能耗損。

對於輕量化程式而言,A100 80GB也能透過多執行個體GPU(Multi-instance GPU,MIG)技術,將GPU切分為7個執行個體,每個體配置10GB的記憶體,構成安全無虞的硬體分隔區,為各種規模較小的作業負載提供最高的資源使用率,可以提升RNN-T這類自動語音辨識模型的AI推論的吞吐量達1.25倍。

另一個例子是將A100 80GB應用於氣象預報及量子化學等科學應用方面,以單節點 A100 80GB系統執行Quantum Espresso材料模擬軟體,可以提升資料產出量達接近2倍。

運算平台同步升級

受益於A100 80GB的出現,NVIDIA也推出了共有640GBGPU記憶體的DGX A100 640GB運算平台,讓使用者能快速提升平台的記憶體容量。

另外NVIDIA也推出了規模較小的DGX Station A100,它搭載4個透過NVLink互連的A100 80GB,可提供2.5petaflops的AI效能和多達320GB的GPU記憶體,也能透過多執行個體GPU技術的切分為28個獨立執行個體,在不影響系統效能的狀況下,支援多個使用者進行平行作業,適合用於企業辦公室、研究機構、實驗室或家庭辦公室的團隊,加速艱鉅的機器學習和資料科學作業負載任務。

另一方面為了解決工作站資料傳輸的需求,NVIDIA推出Mellanox 400G InfiniBand,作為AI超級電腦業界中最強大的解決方案,能夠提供3倍的交換器埠密度,並將AI加速力提升32倍,也讓交換器系統的聚合雙向處理量遽增5倍,達到每秒1.64petabit,並讓用戶在限制更少的情況下運行更大型的作業負載。

NVIDIA這次發表的多款產品將為AI運算注入更充沛的效能,NVIDIA深度學習應用研究部門副總裁Bryan Catanzaro表示:「若想獲得高效能運算(HPC)與人工智慧最頂尖的研究成果,就必須建立極龐大的模型,而這也代表將會需要比過去更多的記憶體容量和傳輸頻寬。A100 80GB GPU提供比6個月前推出的前一代GPU多1倍的記憶體容量,還突破每秒2TB的頻寬瓶頸,讓研究人員能克服全球最重要的科學與大數據研究難題。」。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!