ADVERTISEMENT

機器是怎麼「看」世界的?

透過一格格的影像。

傳統的圖像感測器會透過每秒捕獲多張靜止圖像來記錄場景運動。

如果將這一系列圖像通過足夠快的速度連續展示,人類視覺就能產生「這是連續運動」的錯覺。

但對於電腦來說,無論是多快的速率,影格與影格之間總會遺失某些運動訊息。

那麼,有沒有辦法讓機器連續地「看」到運動場景或事件呢?

今天就來看看普諾飛思(Prophesee)公司的「神經擬態機器眼」解決方案。

來自人眼的啟發

要了解這個「機器眼」,首先得看看它模仿的源頭:

人眼。

我們是如何透過人眼來看世界的呢?

當眼睛中的視覺細胞感測到場景變化——即發生了某個事件時,它就會將相關訊息通過視神經傳到大腦皮層。而收集到的數據也是持續的,是以事件為基礎的。

因此,普諾飛思的研究者們以人眼為啟發,提出了基於事件的視覺感知技術。

和傳統圖像感測器不同,在基於這種技術的感測器中,每個像素都是非同步且獨立的。

因此,圖像訊息並不是逐格發送,而是透過連續的訊息流捕獲事件運動:

而如果從事件的角度來考慮,靜止和場景並不會帶來新的訊息。

因此,這種技術也就不關注完全靜止的場景:

只有場景中發生某個事件,產生了變化時,感測器才會產生輸出:

如果是以影格為單位來獲取這種圖像訊息的變化,那得一張一張固定頻率發送,然後一個像素一個像素的比較。

而現在,只關注動態變化,也就剔除了很多多餘訊息,減少了處理數據量。

這不僅加快了處理速度,也意味著對算力要求的減弱,成本也就隨之降低。

普諾飛思的CEO兼創辦人Luca Verre對此表示:

這是來自自然界的完美的解決方案。

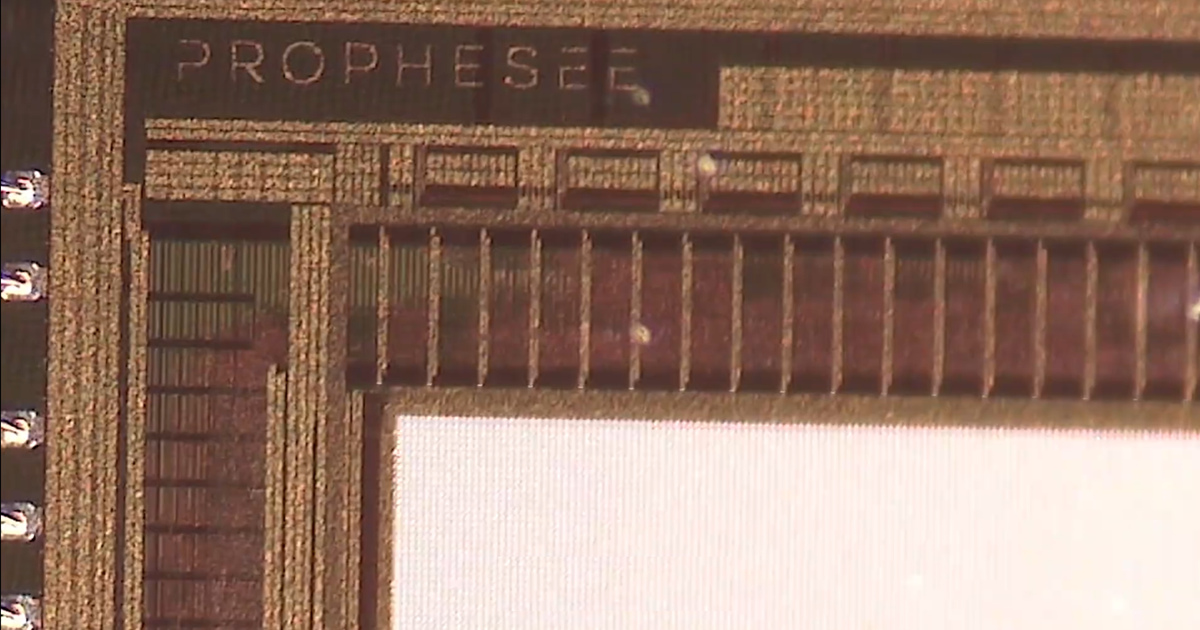

現在,普諾飛思已將這種基於事件的視覺技術整合到已有系統中,生產了世界上首個基於事件的視覺感測器。

並且隨著更新換代,感測器的性能越來越好,尺寸也越來越小了。

更清晰的拍照,更準確的駕駛

更小,也就意味著離我們的日常生活更近。

例如手機拍攝。

如果在按下快門的幾毫秒內被拍對象恰好發生了移動,那麼圖像的一個點就會變成一條線。

這也就是我們在拍攝很多動態物體時常常產生模糊的原因。

但現在用基於事件的視覺技術,就能夠在按快門的這段時間內一直觀測這一點的移動,知道它的移動軌跡,再將這條線恢復成點。

可以看到,採用基於事件的視覺技術的右圖明顯比左圖要清晰很多。

此外,這一技術也能提供更大的動態範圍,讓每一個像素都能按照不同的曝光值來曝光。

這樣,即使在非常嚴苛的光線情景(如室內或夜景)下,拍攝圖像也不會得到很大的損失。

然後就是提供更精準的座艙監控技術。

可以看到,這一監控能夠追蹤駕駛的目光方向。

不僅如此,連眨眼速度也能監控,這可是傳統的監控解決方案做不到的。

這就是普諾飛思聯合Xperi開發的全球首個基於神經擬態視覺系統的駕駛監控解決方案。

除此之外,工業上也有這種感測器的應用:

例如對於一些不能直接接觸的大型機械(如高壓環境)可以做非接觸性的振動檢測。

在焊接上也可以做到引導和質檢。

Prophesee

普諾飛思(Prophesee)是一個7年前在巴黎創立的公司。

這家科技公司致力於神經擬態視覺系統的研發,其基於事件的視覺感測器已應用在攝影、自動駕駛、工業自動化、醫療等多個領域。

這家科技公司致力於神經擬態視覺系統的研發,其基於事件的視覺感測器已應用在攝影、自動駕駛、工業自動化、醫療等多個領域。

公司CEO兼聯合創辦人Luca Verre擁有米蘭理工大學和巴黎中央理工學院的物理學、電子和工業工程雙碩士學位。

還曾任豐田汽車公司和Altis半導體公司的工程師。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!