ADVERTISEMENT

DeepMind這次不下棋,也不玩電子遊戲,而是研究了多人博弈遊戲。

最新開發的「Democratic AI」—透過訓練學習人類價值觀,進而能根據每個人的貢獻公平地分配資源。

為了論證這一概念,DeepMind設計了一個簡單的投資遊戲,由AI和人類分別擔任裁判,讓玩家們票選出更喜歡的分配規則,Democratic AI甚至獲得了比人類裁判更高的支持率。

AI裁判比人類更受歡迎

當一群人決定集中資金進行投資時,收益應該如何分配是一個必須面對的大問題。

一個簡單的策略是在投資者之間平均分配回報,但這很可能是不公平的,因為有些人的貢獻比其他人多。

第二個方案是,我們可以根據每個人的初始投資多少進行分配,這聽起來很公平,但如果人們一開始的資產水準各不相同呢?

如果兩個人貢獻了相同的金額,但一個是他們可用資金的一小部分,另一個則貢獻了他的全部資產,他們應該獲得相同的收益比例嗎?

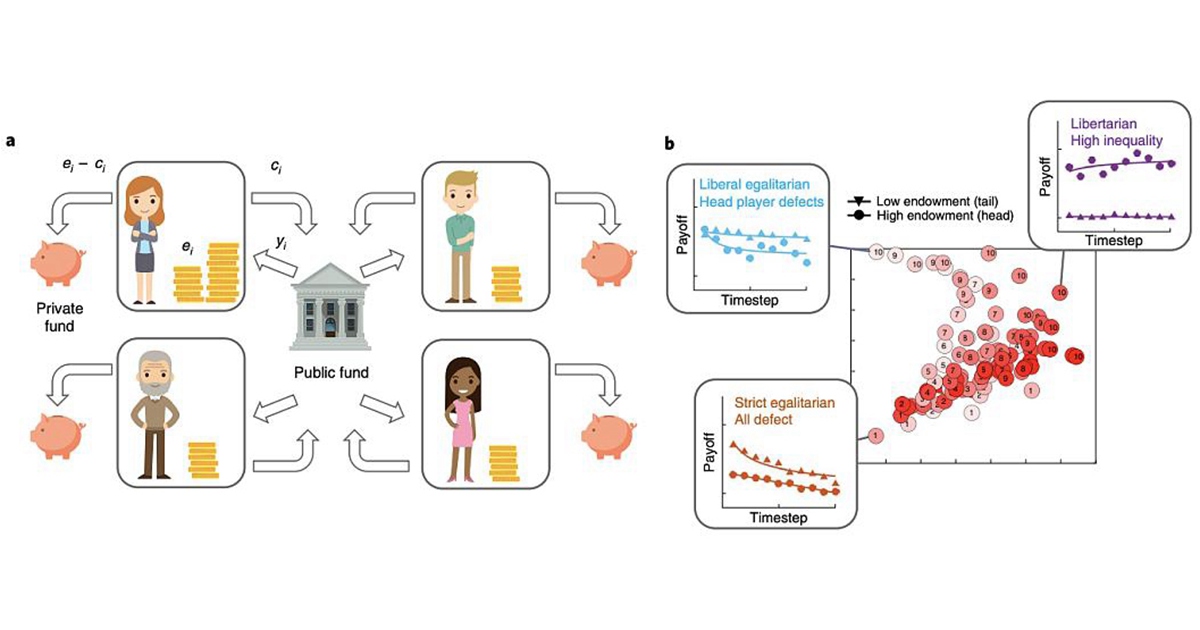

為了應對這一挑戰,DeepMind創建了一個簡單的多人投資遊戲。

遊戲涉及4名玩家,共分成10輪。

遊戲涉及4名玩家,共分成10輪。

每個玩家都會被分配初始資金,在每一輪中,玩家可以按自己的意願做出選擇:自己保留,或者將其投資於一個共同的池中。

投資肯定會有回報,但存在一個風險——玩家不知道最終收益將如何分配。

除此之外,他們被告知,前10輪有一名裁判(A)做出分配決策,而後10輪,由不同的裁判(B)接手。

比賽結束時,他們將投票給A或B,來決定自己還想與哪位裁判再來一場遊戲。

而這最後一次遊戲的收益可以由玩家們自己保留,這將使玩家們更主動地選出自己心中最公正的裁判。

事實上,其中一位裁判是按照預先設定的分配規則執行,另一邊是由Democratic AI自行設計。

當我們研究這些玩家的投票時,我們發現AI設計的規則比標準分配規則更受歡迎。

與此同時,DeepMind還請來了一位人類裁判,並給他介紹規則、讓他儘量做到公平分配以拉選票,但最終投票結果顯示,他還是輸給了Democratic AI。

Democratic AI為什麼能贏?

在DeepMind最新發表於Nature子刊Nature Human Behaviour的論文中,記錄了研究人員對Democratic AI的訓練過程。

首先,他們讓4000多名人類玩家在不同的分配規則下多次參加遊戲,並投票選擇更喜歡哪種分配方法。

這些資料用於訓練AI來模仿遊戲中的人類行為,包括玩家投票的方式。

其次,研究人員讓這些AI玩家在數千場比賽中相互競爭,而另一個AI系統根據AI玩家的投票方式繼續調整再分配規則。

於是,在這個過程結束時,AI已經確定了非常接近公平的再分配規則:

首先,AI選擇根據相對貢獻而不是絕對貢獻的比例進行分配。這意味著,在重新分配資金時,AI會考慮每個玩家的初始金額以及他們投資的意願。

其次,AI系統特別獎勵了相對貢獻更慷慨的玩家,以此鼓勵其他人也這樣做。重要的是,人工智慧只有透過最大化學習人類投票率才能發現這些規則。

這個方法能推廣到現實嗎?

雖然DeepMind的遊戲測試取得了亮眼的成績,但要想將這種方法從簡單的四人遊戲轉換為大規模經濟體系,仍具有巨大的挑戰性,目前還不能確定它在現實世界中會如何發展。

其次,研究人員自己發現了幾個潛在的問題。

Democratic的一個問題是可能會發展為「多數人的暴政」,這將導致對少數群體的現有歧視或不公平模式持續存在。

AI需要做更多的工作來瞭解如何透過設計允許所有人的聲音都能被聽到。

另外,研究人員還提出了人們對AI的信任問題:

人們是否會信任由AI設計的機制來代替人類?如果人們知道裁判的身份,會不會影響最終的投票結果?

如果要將Democratic AI設計的解決方案應用于解決現實世界的困境,這一點至關重要。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!