ADVERTISEMENT

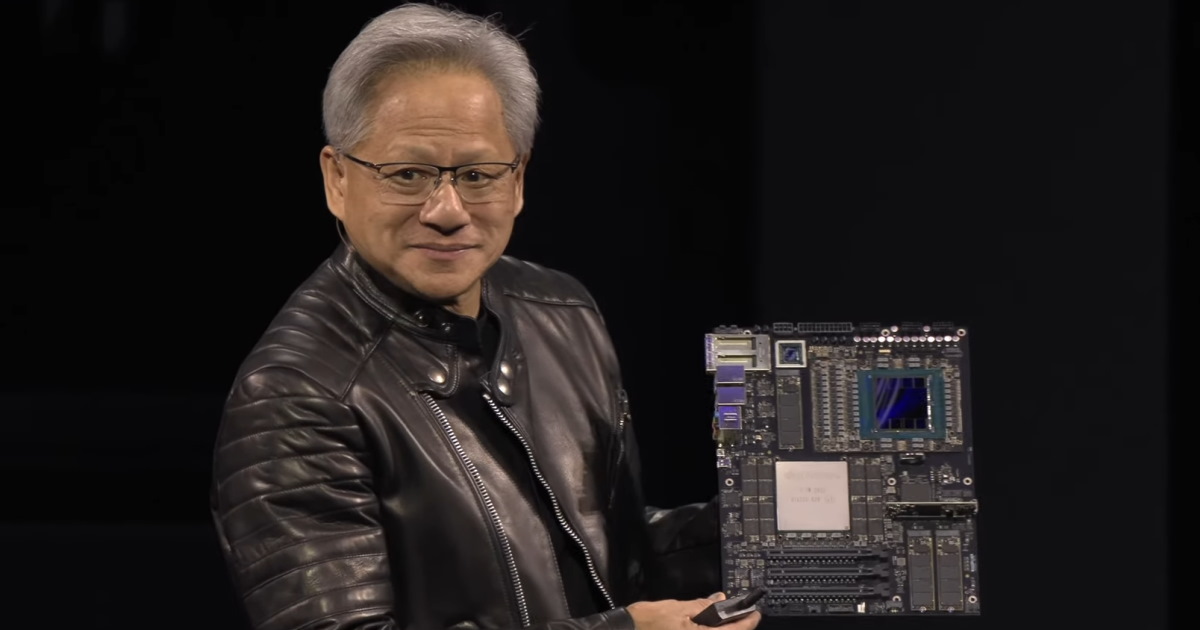

NVIDIA執行長黃仁勳於GTC 2025春季場開幕演說中說明AI發展的多個階段與多種提升準確度的法則,並提出「終極摩爾定律」的發展趨勢觀查。

GTC 2025春季場系列文章目錄:

黃仁勳演說深入分析:提出「終極摩爾定律」,追求相同耗電更高效能(本文)

NVIDIA發表Blackwell Ultra GPU、GB300 NVL72伺服器,Photonic矽光子交換器節能又可靠

NVIDIA如何用AI創造AI?自駕車模型訓練與蒸餾技術分析

NVIDIA發表雙系統架構GR00T N1機器人基礎模型,與Disney、Google合作開發Newton物理引擎

AI除了要更快,還要更省電

黃仁勳在GTC(GPU技術大會)2025春季場開幕演說中提到多款專為CUDA(Compute Unified Devices Architectured)架構所設計的加速運算函數庫,其中包含下列眾多成果

- cuNumeric: Python程式數值運算加速函數庫

- cuLitho:運算式微影加速函數庫(電腦王報導),針對運算式微影(Computational Lithography)技術開發的函數庫

- Aerial、Sionna:5G與6G電信訊號處理(電腦王報導)

- cuOPT:路線規劃最佳化

- Parabricks:加速基因序列分析

- Monai:開源醫學影像領域AI框架(電腦王報導)

- Earth-2:地球的數位孿生(電腦王報導)

- cuQuantum、CUDA-Q:加速量子運算模擬(電腦王報導)

- cuEquivariance、cuTensor:分子結構與線性代數加速函數庫

- TRT-LLM、Megatron、NCLL、cuDNN、Cutlass、cuBlas:深度學習加速函數庫

- cuDSS、cuSparse、cuFFT、AMGX:能夠應用於CAE(電腦輔助工程)的:直接稀疏求解器(Direct Sparse Solver)、用於稀疏矩陣的線性代數、快速傅立葉變換、GPU加速求解器等函數庫

- cuDF、cuML:資料科學與資料處理加速函數庫

- WARP:物理模擬加速函數庫

讓使用者能可以更便捷地導入各種加速運算。

黃仁勳也在演說中提到AI技術發展的多個階段,從2012年的AlexNet卷積神經網路開始,經歷了能夠應用於語音辨識、醫療影像辨識的感知式AI(Perception AI),以及能夠產生多種文字、影像、影片的生成式AI(Generative AI),到近期相當熱門,能夠自動整合多種AI工具並自主進行決策的代理式AI(Agentic AI),以及可以應用於自駕車、機器人的物理式AI(Physical AI),每個階段都提供了截然不同的功能,但也需要消耗更多運算能力。

黃仁勳接著說明提高AI準確度的3種擴充法則(Scaling Laws),第1種是準備大量資料並從無到有訓練基礎模型的預訓練(Pre-Training),第2種則是在基礎模型之上透過特定專業領域資料進行微調的後訓練(Post-Training)。

最後則是推理式AI(Reasoning AI)採用的測試時訓練(Test-Time Training),這種概念會將問題拆分為多個次要部分並按部就班進行「多方思考」與「反覆思考」,並且參考過渡期的答案反問是否合理。簡單來說,在推論運算過程中,AI系統會分析源頭問題,然後自行生成很多次要問題,然後在一一回答次要問題的過程自我修正,最後輸出準確度更高的答案。這個方式的挑戰在於生成次要問題時,但是需要生成更多字詞(Token),而造成總體運算量大幅提升的副作用。

黃仁勳以安排婚禮座位為例說明,利用Llama 3.3 70B大型語言模型(Large Language Model,以下簡稱LLM)進行一般推論運算,過程只需生成439個字詞就可得到答案,但是安排卻不恰當。如果使用DeepSeek R1 671B LLM(透過MoE啟用其中37B參數)進行推理式AI運算,雖然會讓需要生成的字詞數量提升近20倍達到8559個,並讓整體運算量飆升至150倍,但是得到的結果具有實用價值,能夠合適安排的座位,並安排1位牧師作為和事佬。

有趣的是,雖然一般LLM看似節省運算資源,但是得到的結果不堪使用,等於白白浪費439個字詞的運算資源,而推理式AI高漲運算需求,則可靠針對推理式AI最佳化的Dynamo AI推論軟體以及更強大的運算單元舒緩。

Dynamo說明可參考先前《GTC會前簡報》一文。黃仁勳則在演說中補充,Blackwell架構在Dynamo的協助下,可以帶來25倍於前代Hooper的效能輸出,意為著能夠提高AI資料中心25倍產能。

另一方面,今日電力已經成為資料中心營運的核心條件,更高的電力效率代表對周圍供電網路的壓力較輕,以及較低的整體持有成本(TCO)。黃仁勳也表示這種在相同電力下的效能成長幅度,將成為下一個衡量半導體技術發展的「終極摩爾定律」(Ultimate Moore's law),而以同樣消耗100 MW電力的AI資料中心為例,使用GB200 NVL72建構的運算叢集能帶來40倍於H100 NVL8的字詞收益(Token Revenue),因此黃仁勳又提到「The more you buy, the more you save」。

明年推出全新CPU、GPU架構

NVIDIA採用類似Intel Tick-Tock的時程規劃產品開發節奏,在第1年推出新的GPU架構,並在第2年改進架構、推出加強版產品,對照本世代產品便是2024年發表的Blackwell GPU架構,以及預計2025年下半推出的Blackwell Ultra架構。

Blackwell Ultra之GPU晶片中封裝了2組裸晶,總共具有15 PFLOS之FP4資料類型運算效能,並搭載容量高達288GB之HBM3e記憶體。而GB300 NVL72伺服器採用機架規模設計,整合36組Arm Neoverse架構Grace CPU與72組Blackwell Ultra GPU,總計有20TB HBM高頻寬記憶體以及40TB DDR記憶體,FP4資料類型AI運算效能高達1.1 EFLOPS。

到了2026年下半,NVIDIA將同時推出全新的Vera CPU架構以及Rubin GPU架構,前者採用88核176緒配置的客製化處理器核心,而後者則在單一GPU晶片中封裝2組裸晶,將運算效能提升至50 PFLOS,並搭載288GB HBM4高頻寬記憶體。此代架構也同時導入頻寬達3600 GB/s的第6代VNLink互連技術,並升級至Spectrum 6與ConnectX 9 InfiniBand網路介面卡。

至於2027年下半則輪到Rubin Ultra架構,它最大的改變在於將會在單一GPU晶片封裝內整合4組裸晶,將運算效能提升至100 PFLOPS,並搭載1TB HMB4e高頻寬記憶體。

值得注意的是,黃仁勳也在演說中承認Blackwell的命名明方式有可改進之處。Blackwell GPU的我們「肉眼可見」的單一晶片封裝(Chip Package)具有2組裸晶(Die),而每組GB200 Superchip具有2組Blackwell晶片封裝、共4組裸晶,因此由36組GB200 Superchip組成的GB200 NVL72伺服器,具有72組Blackwell晶片封裝、共144組裸晶。

而在Vera Rubin世代的伺服器將改以裸晶數量進行命名,因此將晶片配置數量與GB200 NVL72伺服器接近的產品並非命名為「Vera Rubin NVL72」,而是「Vera Rubin NVL144」,並非增加1倍晶片數量。

而在這之後,預計於2028年下半推出的產品將沿用Vera CPU架構,並升級至全新Feynman GPU架構,搭配第8代VNLink互連技術以及Spectrum 7、ConnectX 10 InfiniBand網路介面卡。

(下頁還有矽光子、工作站、自駕車、機器人介紹)

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!