企業自主 AI 解決方案品牌 APMIC 宣布與繁體中文語言模型研究社群 Twinkle AI 攜手合作,正式推出台灣首個可於手機端運行的 3B 參數繁體中文推理模型「Formosa-1」;雙方亦聯手開源高效評測框架「Twinkle Eval」,共同推動台灣 AI 技術發展與本地化應用。

台灣首款手機端 3B 繁體中文推理模型 Formosa-1

Formosa-1 是由 APMIC 與 Twinkle AI 社群研發,並在國家高速網路與計算中心研發團隊的技術支持與經驗分享下所開發,是台灣首款可於手機端運行的 3B 參數大型語言模型。該模型透過基於 NVIDIA NeMo 端對端平台的 APMIC PrivAI 產品模型蒸餾技術進行訓練,並以 MIT 授權方式完全開放模型權重,以助推動臺灣繁體中文開源 AI 的發展。

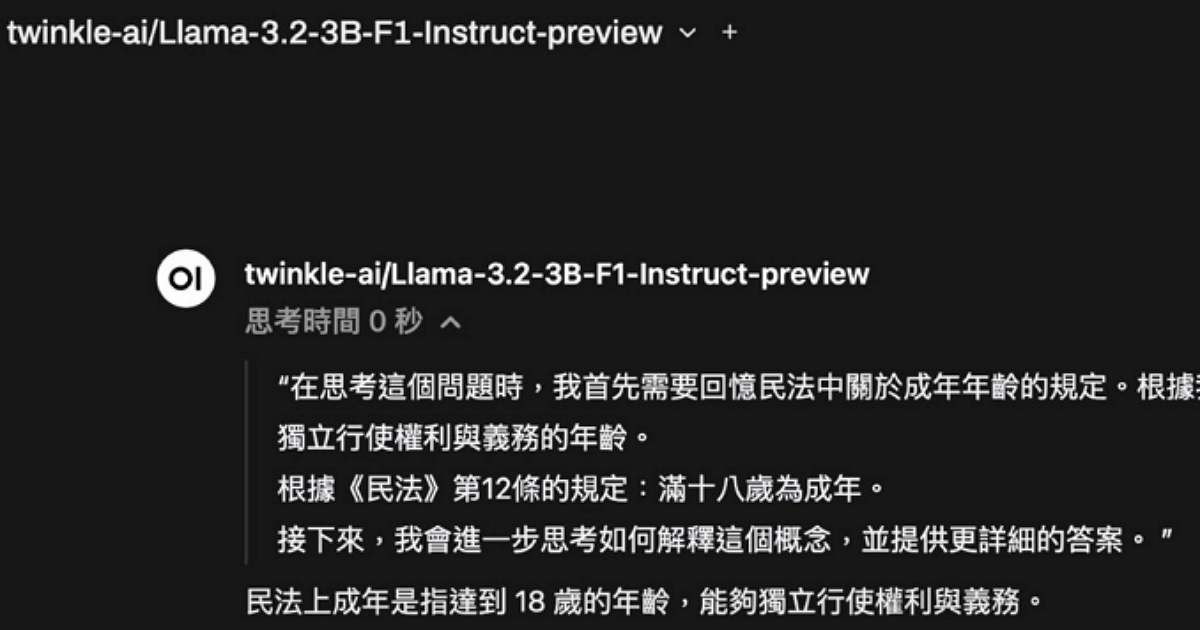

為提升其模型推理能力,Formosa-1 使用了貼合台灣本地思維鏈的資料,並搭配 NVIDIA NeMo Data Curator 加速資料管理服務,確保在法律推理、邏輯思辨與數學推演方面展現卓越表現。語言資料建構方面,Formosa-1 的訓練數據涵蓋 100B 規模的高品質繁體中文 Tokens,包含新聞、法律、論文、社會討論等多元文本,以確保 AI 對繁體中文語境的精準理解與應用。

專為大型推理模型打造的評測工具 Twinkle Eval

AI 模型的效能取決於評測機制的效能,傳統評測工具的逐題推論順序式流程在龐大的題目數量或運行時需要較長推論時間跟算力,嚴重制約了評測效能與資源使用效率。為此,APMIC 與 Twinkle AI 社群共同開發一款專為大型推理模型設計的開源評測框架「Twinkle Eval」,該評測工具與 NVIDIA NeMo Evaluator 評估模型進行深度整合,支援大規模並行測試,確保模型在多領域的穩定性與準確性。

Twinkle Eval 透過隨機化選項排序來確保測試公平性,避免模型記憶固定選項順序,並引入重複測試機制,透過多次獨立推論來驗證模型的穩定性。此外,該工具內建台灣通識與專業能力混合題庫(TMMLU+)、台灣法律語料測試集(tw-legal-benchmark-v1)及 MMLU 基準測試集,確保測試範圍的廣度與準確性。透過格式精控與錯誤修復機制,Twinkle Eval 能夠有效確保答案格式的統一性,並降低測試錯誤率。

在MMLU(Massive Multitask Language Understanding)語言理解挑戰中,Formosa-1透過Twinkle Eval進行評測,獲得52分的成績,相較於原生Llama-3.2-3B-Instruct提升了46分,展現其在推理能力上的優勢。這項成果證明,透過在地語言技術的強化與精準數據訓練,台灣 AI 技術已與國際標準接軌,能夠進一步為產業應用提供更高效的解決方案。

- Formosa-1:https://huggingface.co/twinkle-ai/Llama-3.2-3B-F1-Instruct

- Twinkle Eval:https://github.com/ai-twinkle/Eval

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!