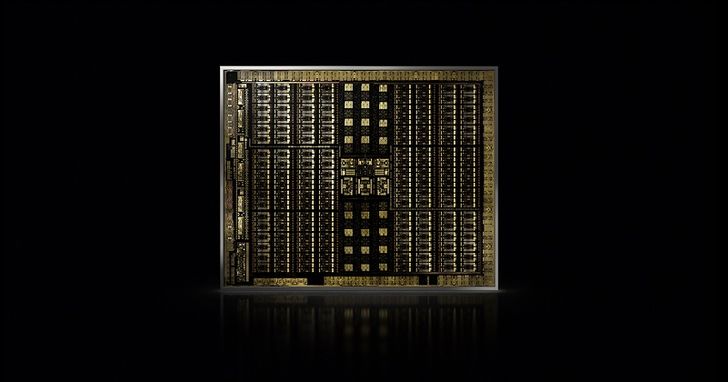

NVIDIA (輝達) 宣佈透過全新推出的 NVIDIA Turing GPU 架構重新定義電腦繪圖。Turing 是自 CUDA GPU 在2006年發明以來最重要的里程碑,其搭載全新用於加速光線追蹤的 RT 核心與用於 AI 推論的新一代 Tensor 核心,首度整合攜手實現即時光線追蹤。

此兩款動能結合更高的模擬運算效能與優化的光柵化技術,能為價值2.5兆美元的視覺特效市場帶來新一代混合式渲染,能有電影特效級的互動體驗、藉由神經網路驅動新特效,以及在高度複雜的模型中順暢的互動。NVIDIA 同時也推出首款搭載 Turing 架構的系列產品,包含 NVIDIA Quadro RTX 8000、Quadro RTX 6000與 Quadro RTX 5000 GPU。

NVIDIA 創辦人暨執行長黃仁勳在年度 SIGGRAPH 大會開場時表示:「Turing 是 NVIDIA 近 10幾年來最重要的發明,混合式渲染將改寫產業,激發更多令人驚豔的潛能,透過更出色的作品、更豐富的娛樂與更多的互動改善我們的生活,即時光線追蹤的到來是我們這個產業夢寐以求的聖盃。」

為協助開發者能完全掌握新功能所帶來的優勢,NVIDIA 透過全新 AI、光線追蹤技術與模擬開發套件強化其 RTX 開發平台,並宣佈針對數百萬名計畫透過 RTX 開發平台驅動 Turing 效能的設計師、藝術家與科學家推出關鍵繪圖應用。

全新RT核心加速即時光線追蹤

Turing 架構搭載全新專為光線追蹤所設計的 RT 核心,它能以高達每秒10 GigaRays 的效能加速光線與聲音在3D 環境中傳遞的計算,提供比前一代 Pascal 架構快25倍的即時光線追蹤執行效能。此外,其 GPU 節點能為電影特效完成前,針對每幀畫面提供比 CPU 節點快30倍的渲染效能。

Cinesite 技術長 Michele Sciolette 表示:「Cinesite 很榮幸能與 Autodesk 和 NVIDIA 合作將 Arnold 技術與 GPU 整合,但我們從未想過這項合作會帶來如此令人注目的成績。這代表我們將能執行更快、更密集與更高品質的設定,徹底改變藝術家的作業流程。」

Tensor 核心針對AI進行加速

Turing 架構亦搭載新 Tensor 核心處理器,能為深度學習訓練與推論執行每秒高達500兆的效能。此等級的效能可以透過經 AI 優化的功能創造新的應用。其中包含 DLAA (Deep Learning anti-aliasing),其為降噪、畫質調整與影片時間重置等。

Turing Streaming Multiprocessor加速模擬與光柵化技術

Turing 架構 GPU 同時具備全新 Streaming multiprocessor (SM) 技術,其能透過浮點資料路徑與比前一代高兩倍頻寬的全新整合快取架構,執行完整參數的平行運算。

透過整合如可變速遮蔽、紋理空間遮蔽與多元視角遮蔽等新繪圖技術,Turing SM 能針對每個核心達到前所未有的效能優化,此外,Turing 也能同時藉由最多4,608個 CUDA 核心以高達16兆次的效能執行浮點運算與完整參數運算的平行運算。

開發者可以利用搭配 NVIDIA CUDA 10與 Flex 和 PhysX 開發套件,來執行如流體動態、科學視覺化、虛擬環境與其他特殊特效等複雜的模擬作業。Turing 預計將隨搭載其架構的 Quadro GPU 於第四季上市。

想看小編精選的3C科技情報&實用評測文,快來加入《T客邦》LINE@

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!