Apple在其A系列處理器中推出了第二版「神經網路引擎」(neural engine),呼籲開發者在行動設備上為機器學習(ML)引入更多用例。這應該有助於人工智慧(AI)在智慧型手機上的普及。

在AI更廣泛的領域內,機器學習中最棘手的問題之一,就是找出電腦應該解決的問題。只有當某件事情被框定為尋找問題的解決方案時,電腦才能夠學習和理解。蘋果正試圖透過吸引開發者使用其晶片和軟體程式設計工具來為行動裝置上的神經網路提供新的應用範例,來應對這一挑戰。

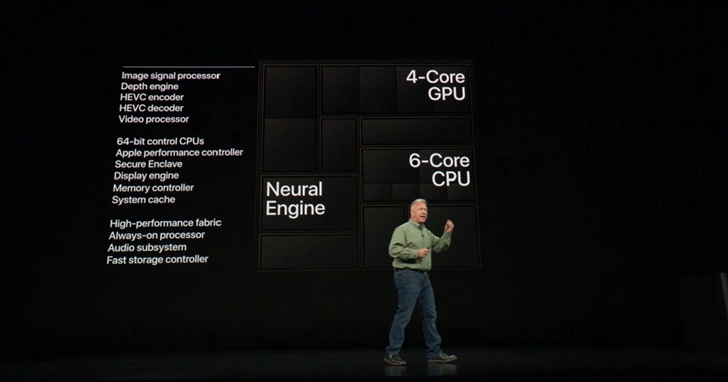

週三在庫帕提諾(Cupertino)總部舉行的新品發佈會上,蘋果討論了iPhone XS、iPhoneXS Max和iPhoneXR的「神經網路引擎」。「神經網路引擎」是iPhone的A系列處理器的一個部分,專門用於研究機器學習工作負載。

今年的A12晶片採用的是「神經網路引擎」的第二個版本,它於去年首次在iPhone X的A11處理器上亮相。新版「神經網路引擎」有8個核心,高於之前的2個。蘋果公司表示,這使得電路可以每秒處理5兆次運算,而去年這個數字為6000億次。

如何利用這些專門的計算能力本身也存在問題。蘋果有些建議,但它顯然希望開發者使用其機器學習程式設計開發工具包Core ML來填補空白。去年的iPhone X已經使用「神經網路引擎」進行臉部辨識。昨天,該公司的行銷主管菲爾‧席勒(Phil Schiller)討論了iPhone XS現在如何讓「神經網路引擎」與晶片的另一個領域,即專門用於照片處理的功能——圖像訊號處理器共同工作。

綜合起來講,「神經網路引擎」可以幫助圖像訊號處理器創建更清晰的「分割掩模」,以辨別人臉在圖像中的特徵。這可以用來改善在拍攝人像時對臉部的照明。為了展示開發者可以做什麼,蘋果邀請Nex Team上台,這是個正在構建增強現實(AR)應用程式的初創公司。他們展示了如何使用籃球影片訓練球員。

在諮詢了鳯凰城太陽隊(Pheonix Suns)前球星、現任職業教練的史蒂夫‧奈許(Steve Nash)後,Nex Team公司開發出一個程式,可以拍攝影片,並即時跟蹤影片中球員在籃筐前練習投籃的姿勢。這種應用程式還可即時繪製籃球的飛行軌跡,並收集各種其他指標。因此,訓練可以被重新定義為一個ML問題,即如何使用行動影片來衡量佐證最佳運動員表現的統計資料。

與像Nex Team這樣的開發者簽約是一種方式,可以讓蘋果和其他不同晶片開發者保持一定的距離,這些晶片開發商要嘛是為了開發AI而研製商用矽,要嘛是為了讓自家手機變得更加強大而加強內部努力。例如,晶片巨頭高通(Qualcomm)在其驍龍行動處理器生產線中加入了AI。華為在其智慧型手機的麒麟晶片中植入了AI電路,三星也在其Galaxy智慧型手機上採用了Exynos處理器。

晶片研究公司林利集團(the Linley Group)首席分析師林利‧格溫納普(Linley Gwennap)說,就像數位訊號處理器(從CPU那裡接管數學功能,比如視訊解碼)一樣,機器學習電路正在預測行動裝置中ML工作負載的波動

他說:「這遵循了某個公認的路徑,你不希望在很多事情上使用CPU,而把一個普通的函數放到一個單獨的函數模組中總是更有效率。CPU可以運行簡單的神經網路來進行人臉辨識和其他操作,但當你把同樣的任務交給硬體處理器時,比如神經網路引擎,它可以做同樣的工作,而且只需要十分之一的CPU功耗。」

格溫納普舉例稱:「在卷積神經網路中,大約80%的計算是矩陣乘法。」他指的是最常見的機器學習結構之一的「原語」之一。識別這些常見的原語是一種簡單的方法,可以在各種各樣的AI工作負載中提高性能,即使算法會發生變化。

隨著機器學習成為一種更普遍的功能,蘋果可能會在硬體上擁有最好的功能模組,執行越來越多用其核心ML框架編寫的神經網路,進而超越華為和三星等公司以占據優勢。

值得注意的是,在週三的神經網路演講中,沒有出現蘋果自己的智慧助手Siri。Siri的性能褒貶不一,它似乎是手機上某種局部加速功能的不錯選擇。格溫納普表示,Siri的本地處理可能對很多事情很有用,比如讓家裡的燈亮起來。你不需要等待Siri連接到雲端來理解你的語音指令。

他說:「只要Siri出現在你面前就行了,而無需等待到雲端計算的回饋時間,這可能會改善Siri乏善可陳的表現。」

資料來源:Zdnet 作者:Tiernan Ray

本文授權轉載自網易科技

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!