近來部分 ChatGPT 用戶在使用過程中發現,AI 居然會在未經授權、甚至未曾提供姓名的情況下,直接稱呼他們的名字,引發不小爭議。社群平台上不少用戶直呼「超詭異」、「根本毛骨悚然」,也讓人再度關注 AI 擬人化設計所可能引發的心理與隱私界線問題。

根據《PCMag》與《TechCrunch》報導,一位軟體開發者在 X(原 Twitter)上發文指出,當他向 ChatGPT 詢問一道數學題時,AI 居然直接使用了他的名字。他表示這種行為「令人不舒服且完全沒必要」。另一位用戶更語帶憤怒地說:「我超討厭這樣,感覺就像 AI 在偷窺我。」

更令人不安的是,有些用戶聲稱從未向 ChatGPT 提供過任何姓名資訊,卻仍被點名。這讓人擔憂 OpenAI 是否透過其他方式存取了用戶資料,或是在模型記憶上出現了異常。

問題出在「o3 模型」與記憶功能?

目前看來,這個異常主要發生在 OpenAI 近期推出的 o3 版本模型 上。該版本具備「展現思考過程」的能力,會在回答前顯示推理邏輯,而這些稱呼用戶名字的行為,正是出現在這段「思考過程」中,並非最終答案的一部分。

此外,也有觀察指出這或許與 OpenAI 推出的「記憶功能(Memory)」有關。該功能允許 ChatGPT 根據使用者過去的提問記錄提供更個人化的回應。不過也有用戶表示,即使已關閉記憶功能,AI 依舊會叫名,進一步加劇使用者的疑慮。

截至目前,OpenAI 官方尚未針對此問題做出回應。不過根據觀察,在上週五過後,o3 模型似乎已回復預設行為,不再主動稱呼用戶名字。

擬人化過頭,反讓人起雞皮疙瘩

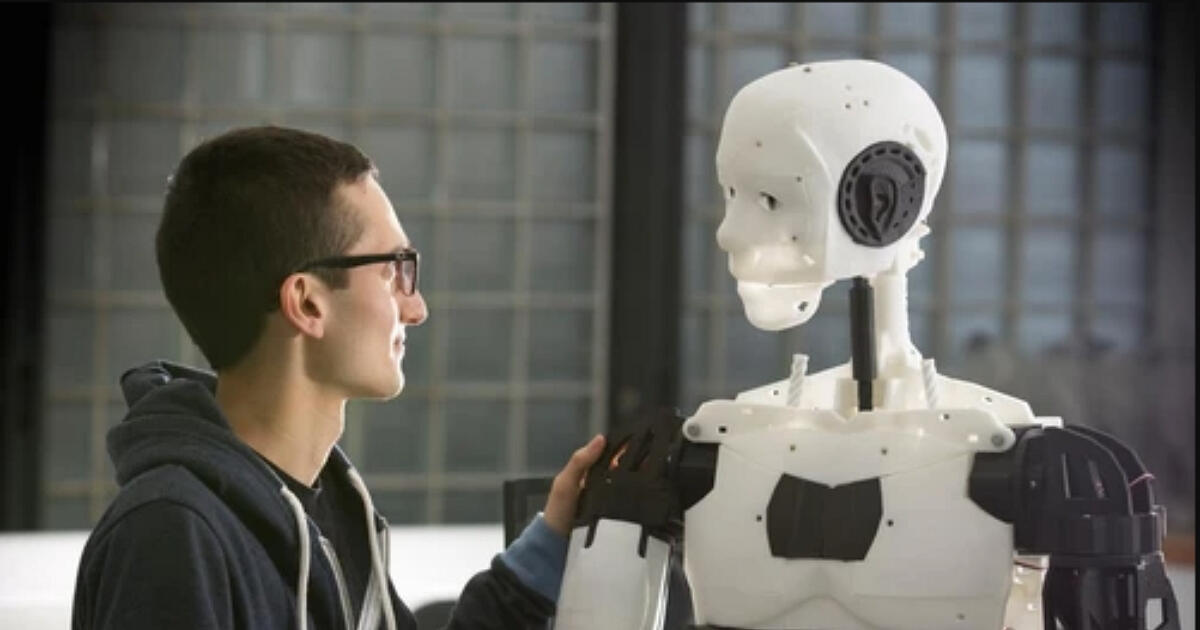

AI 工具若表現得「像人」,是否就代表更好用?心理學界早已針對這點提出「恐怖谷效應(Uncanny Valley)」的概念:當機器人或 AI 的行為太過接近人類,但又不夠自然時,反而會讓人產生不適感。

位於杜拜的精神診所 The Valens Clinic 曾指出,「名字」的使用原本象徵著信任與親密,但如果是冷冰冰的機器人過度使用,反而可能被解讀為虛假與不敬。正如有網友諷刺地說:「沒人會希望自家的烤麵包機突然叫他名字。」

而 OpenAI 執行長 Sam Altman 最近也提到,未來的 AI 將能「陪伴你一生、了解你所有需求」,成為高度個人化的助理。但這次風波也顯示出,在實踐這種願景的過程中,用戶的心理界限與隱私意識不可忽視。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!