如今的AI大型語言模型規模越來越龐大,動輒成百上千億參數,訓練過程不僅需要數萬甚至十幾萬塊GPU加速卡,出錯的機率也越來越高。Meta(Facebook)就披露了一份驚人的報告。

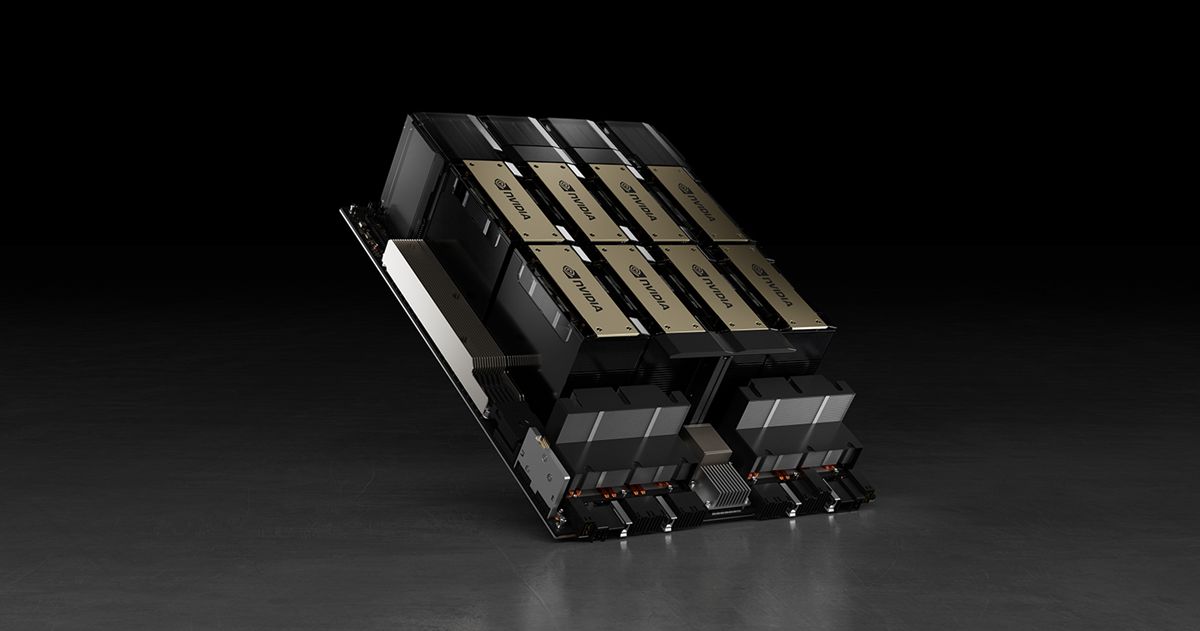

Meta在報告中披露,為了訓練自己的Llama 3 4050億參數大型語言模型,使用了包含16384塊NVIDIA H100 80GB GPU的叢集,一共花了45天,期間居然出現了419次意外報錯,平均每3個小時就一次,而一半的錯誤都和GPU及其自帶的HBM3記憶體有關。

要知道,大型語言模型訓練的工作量異常龐大,而且需要高度同步,一次錯誤就可能導致整個訓練工作必須從頭再來。

報告顯示,為期45天的預訓練階段中,總共出現了466次工作中斷,其中47次是計畫內的自動維護,419次是意外的,且大部分都來自硬體問題,GPU又是最多的,佔了其中的58.7%。

具體來說,148次即30.1%的意外中斷來自各種GPU失效(包括NVLink匯流排),72次即17.2%來自HBM3記憶體失效——畢竟,700W的功耗太熱了。

還有19次來自GPU SRAM,17次來自GPU處理器,6次來自GPU靜默資料錯誤,6次來自GPU散熱和感測器。

其他錯誤來自軟體bug、網線和網路卡等等各個方面。

有趣的是,CPU錯誤只出現了2次。

還好,Llama 3團隊非常給力,在這麼高的出錯機率下,依然維持了超過90%的有效訓練時間,而且只有三次GPU報錯需要大量人工干預,其他都被自動化管理糾正了。

- 延伸閱讀:馬斯克預告用了10萬張NVIDIA H100卡來訓練Grok 3,預計年底上線

- 延伸閱讀:祖克伯表示「元宇宙跟AI 我都要」,預估年底將擁有 35 萬片NVIDIA H100

- 延伸閱讀:微軟工程師算給你看:NVIDIA H100 AI 晶片總耗電量明年將超越鳳凰城所有家庭總用電量

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!