NVIDIA 執行長黃仁勳近日針對中國人工智慧公司 DeepSeek 所引發的市場疑慮發表了看法,根據外媒 Business Insider 報導,黃仁勳強調,人工智慧(AI)的後訓練(Post-training)才是決定智慧高低的關鍵,並表示這將持續推動對輝達晶片的需求,而非減少。

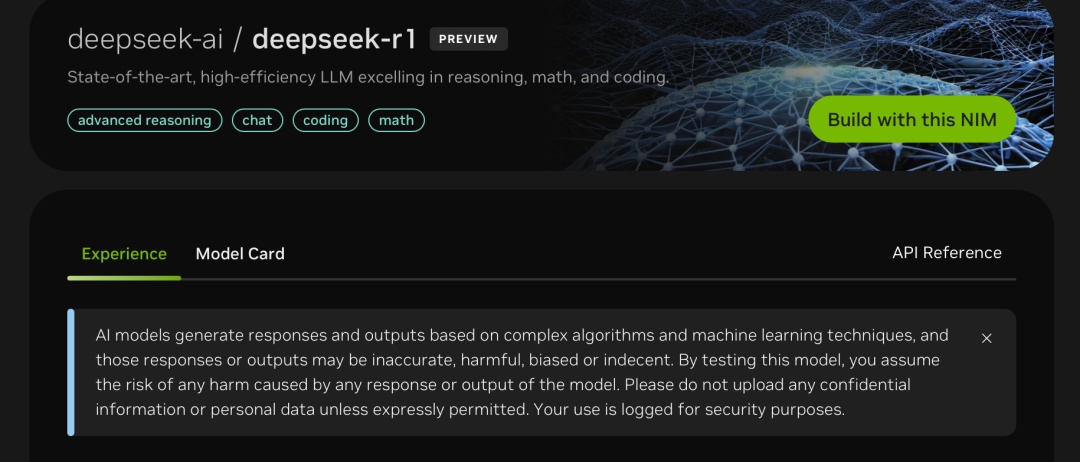

DeepSeek 是一家由避險基金 High-Flyer 擁有的中國 AI 公司,今年一月發布了一款開源推理模型 R1,聲稱其底層的大型語言模型僅用較弱的晶片和一小部分資金構建,成本遠低於西方主流 AI 模型。此消息一出,引發投資者恐慌,猜測如果訓練模型所需的計算能力較少,那麼大型科技公司在人工智慧基礎設施上花費數萬億美元是否還有必要?擔心 AI 模型訓練所需的計算能力降低,將影響輝達的 AI 基礎設施業務,導致輝達股價一度暴跌,市值蒸發 6000 億美元。

黃仁勳在與輝達合作夥伴 DDN 的線上活動中,明確指出市場對 AI 的理解存在誤區,他表示,投資者普遍認為 AI 的流程是「預訓練(Pre-training)+推理(Inference)」,也就是向 AI 提問後立即得到答案,然而,他強調,預訓練固然重要,但後訓練才是「智慧最重要的部分」,是 AI 學習解決問題的關鍵階段。

後訓練是指在 AI 模型完成初步訓練後,透過各種方法進一步優化模型,使其能夠更好地理解和應用知識,做出更精確的判斷和預測,黃仁勳認為,隨著後訓練方法不斷發展和多樣化,對輝達晶片所提供的強大計算能力的需求也將隨之增長。

黃仁勳對 DeepSeek 的創新給予高度評價,認為其開源 R1 模型的舉動,激發了全球 AI 領域的活力,「這太令人興奮了!由於 R1 成為開源,世界各地都充滿了活力,令人難以置信,」黃仁勳說。

事實上,早在 DeepSeek 事件之前,市場就已開始擔憂 AI 模型擴展速度放緩,可能影響輝達的獲利能力,對此,黃仁勳多次強調,AI 的擴展仍然活躍,只是重心從訓練轉向了推理。他表示,後訓練方法「非常密集」,模型將隨著新的推理方法而不斷改進。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!