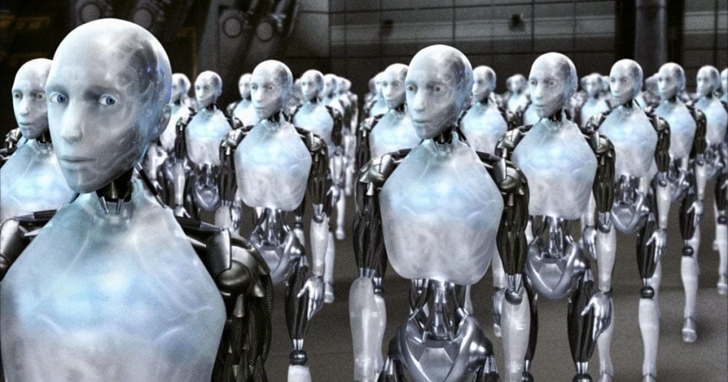

在《魔鬼終結者》(Terminator)中,機器人想完全佔有這個世界,把人類趕盡殺絕。那:「如果電影中場景在現實重演,結果會怎樣?」提出這樣的問題不應該受到指責,因為透過電影和科幻故事,機器人接管地球的場景幾乎無處不在,因此我們對人工智慧(AI)的未來已經形成了這樣的印象。然而,既然人類能夠透過法律維持生存和合作,為何不能把法律也應用到AI身上呢?這就涉及到阿西莫夫的機器人三大定律!為了更好地瞭解未來,我們首先要回顧下過去。

機器人三大定律

以撒‧艾西莫夫(Isaac Asimov,1920-1992)除了是一名生物化學教授,還被認為是他那個時代的「三大」科幻小說家之一。在20世紀中期,艾西莫夫提出了三條定律,如果遵守這些定律,我們就能阻止機器人起義。這三大定律包括:

- 第一定律:機器人不得傷害人類,或因不作為而讓人類受到傷害;

- 第二定律:機器人必須服從人類給它的命令,除非這些命令與第一定律相衝突;

- 第三定律:機器人必須保護自己的存在,只要這種保護不與第一定律或第二定律相衝突。

現在,如果你熟悉程式編輯,你就會知道機器會從0開始計數,而不是從1開始。因此,正如電腦迷所說的那樣,第0條法律指的應該是集體而不是個人。如果這些定律聽起來很熟悉,那是因為它們是在《我,機器人》(I, Robot)這個故事中出現的。值得注意的是,它們在「機器人」(身體)和「人工智慧」(大腦)之間並沒有區別,因為當艾西莫夫提到機器人時,他腦海中出現的是智慧類人生物。

那麼,如果早在20世紀50年代這些定律就已經被制定出來,為何我們還如此懼怕機器人呢?是什麼促使伊隆‧馬斯克(Elon Musk)甚至史蒂芬‧霍金(Stephen Hawking)將AI視為人類「最大的生存威脅」?長話短說,這是因為艾西莫夫的三大定律沒有作用。

計畫中的缺陷

回到現在。為了與艾西莫夫的觀點保持一致,讓我們假設我們確實有足夠複雜的AI來適應這些定律。為了便於討論,我們還假設,儘管它們是敘事機制的法則,但它們也適用於現實世界。

技術問題:如果法律是英文的,而AI只能處理中文會怎樣?或者即使這些AI是在美國製造的,我們怎麼知道它如何理解法律?因此,我們需要一種方法來(i)把法律翻譯成每一種可能的語言,(ii)把這些詞背後的含義傳達給每一種可能的語言(為了涵蓋所有可能的情況,還必須使用拉丁語等已經消亡的語言以及二進制機器語言)。

對於人類來說,這些任務是息息相關的。但對於機器來說,這是兩個截然不同的任務。第一個任務是用不同的語言產生相應的句子字符串,第二個任務是理解這些字符串。如果我告訴你用西班牙語唱《Despacito》,就好比只做第一個任務。你可能說得很好,但你卻不知道它們的意思(假設你不懂西班牙語)。另一方面,只做第二項任務就像腦子裡有了一個想法,卻不知道如何表達。

幸運的是,自然語言處理(NLP)領域在過去的幾年裡經歷了巨大的飛躍。對於第一個任務,具有長短期記憶細胞(Long Short-Term Memory)的神經網路可以用序列-序列的轉換方式。此外,端到端的語音-語音翻譯模型Translatotron,於2019年5月發佈。對於第二個任務,Word2Vec模型已經證明了自己的價值,它將相關的單詞組合起來,進而在句子中產生語義。如下圖所示:

的確,機器現在可以理解語言。然而,它們仍然有很多事情不能做。一個例子就是理解熟語。雖然「spill the beans」可能是「洩露秘密」的比喻意,但目前還無法進行比喻翻譯。因此,機器將逐字逐句地把每個單詞翻譯成對應的單詞。如果按照正確的順序翻譯成法語,那麼這個表達就是「jeter les haricots」,這聽起來肯定給人一種斷章取義的感覺。

但是,為了便於討論,讓我們大膽假設,比喻翻譯問題將在未來幾年得到解決。這樣一來,所有關於讓AI理解法律的技術問題都會得到解決,我們也就安全了,對吧?做好準備,因為這才是有趣的地方!當艾西莫夫提出這些定律時,他不知不覺地把它們建立在另一個假設的基礎上:我們人類確切地知道道德底線應該劃在哪裡。但是我們會遵守嗎?

讓我們以第一定律中的「傷害」一詞為例。在這個定律中,讓我們也考慮一下「人」這個詞的含義。它的定義包括什麼?例如,在14世紀,奴隸被認為比更接近牛等牲畜。現在,胎兒的生命權是許多討論的主題。然而,將來,如果一名孕婦由於某種疾病,在分娩時死亡的幾率很高,她的AI醫生應該建議墮胎嗎?人們需要記住的是,雖然從邏輯上講,女性在墮胎中存活的幾率更高,但胎兒一旦出生,就有更多的生存空間。所以,不管怎樣,機器人最終傷害了人類。

接下來的決定甚至會讓我們人類陷入否認的狀態。讓我們考慮一下丹‧布朗(Dan Brown)描述的地獄場景,並應用第零條定律。AI將顯示一個按鈕,並被告知,如果它按下按鈕,一半的人類會立刻死亡,但是這個物種會存活幾個世紀。如果不這樣做(因此,不作為),人類將在50年內達到人口過剩狀態,我們的物種將崩潰。如果你處在AI的位置,你會怎麼做?

結論

艾西莫夫的機器人定律試圖解決AI起義的威脅。使機器人遵守這些定律的技術障礙是我們目前在使它們理解法律方面的限制。真正的障礙(哲學和倫理上)可能是我們的假設,在如此模糊的限制下,機器人將會按照我們想要的方式行動,即使我們不知道自己的意思。即使我們傳達的意思是正確的,這些定律也可以簡單地改為「不管怎樣,只要做好就行,對嗎?」而到那時,它們可能已經造成了不可挽回的影響。

請注意!留言要自負法律責任,相關案例層出不窮,請慎重發文!